Geschichte der Elektrolyse

Die Geschichte der Elektrolyse beschreibt die wichtigsten Schritte, die zur Entdeckung der Elektrolyse führten und die nachfolgenden Fortschritte bei ihrer technischen Anwendung.

Entdeckung der Elektrolyse, neue Synthesen, Verbindungen und Elemente, erste Theorien

[Bearbeiten | Quelltext bearbeiten]

A. P. van Troostwijk und R. Deiman führten bereits 1789 eine Elektrolyse des Wassers durch. Als Spannungsquelle benutzten sie eine Elektrolysiermaschine, die im Rijksmuseum Boerhaave in Leiden zu besichtigen ist.[1] Die erste brauchbare und leistungsfähige Batterie, die Voltasche Säule, war vom italienischen Physiker Alessandro Volta 1799 fertiggestellt worden. Sie war die erste Spannungsquelle überhaupt, die einen längeren Stromfluss bewirken konnte. 1800 berichtete Volta seine Entdeckung dem Präsidenten der Royal Society, Joseph Banks. Noch im selben Jahr wurden die ersten Elektrolysen durchgeführt: William Cruickshank zersetzte Salzwasser. William Nicholson und Anthony Carlisle zeigten, dass aus Wasser mit Strom aus der Voltaschen Säule zwei Gase im Verhältnis 2:1 entstehen. Johann Wilhelm Ritter konnte durch die Knallgasprobe und mittels weißen Phosphors nachweisen, dass die beiden Gase Wasserstoff und Sauerstoff waren.

Ritter setzte bereits im Jahre 1799 mit jeweils zwei Metallblechen verschiedene Spannungsketten zusammen, so dass er eine erste Spannungsreihe von unedlen bis zu den edlen Metallen erhalten konnte. Ritter erkannte auch, dass bei der galvanischen Stromerzeugung chemische Reaktionen ablaufen.[2] Humphry Davy untersuchte die Säure- und Basebildung mittels Lackmuspapier und konnte so bereits die Wanderung der Ionen im Verlaufe der Elektrolyse studieren.

Theodor Grotthuß (1785–1822) gab im Jahr 1805 eine erste Theorie der Wasserzersetzung an. Er nahm an, dass durch die Spannung positive Wasserstoffteilchen und negative Sauerstoffteilchen entstünden. Unklar blieb jedoch nach dieser Theorie der Einfluss von Salzen, Säuren, Basen auf die elektrolytische Abscheidung. 1802 erhielten Hisinger und Jöns Jakob Berzelius Chlorat auf elektrochemischem Weg aus Kochsalz, wobei sie das Ergebnis noch nicht schlüssig belegen konnten. Kolbe bestätigte aber 1847 die Chloratbildung auch aus Hypochloriger Säure. Hisinger und Berzelius vermuteten, dass Moleküle (Atome) einen positiven und einen negativen Pol hätten (elektropositiv, elektronegativ) – ähnlich wie ein Magnet.

Humphry Davy entwickelte eine Versuchsanordnung, bei der sich der positive und der negative Pol in zwei getrennten Gefäßen befanden. So konnte er zeigen, dass sich aus einer Natriumsulfatlösung am negativen Pol eine schwache Natronlauge bildet und am positiven Pol schwache Schwefelsäure. Er untersuchte dann 1805–1807 auch die Elektrolyse geschmolzener Salze, wobei er als Kathode einen Platinlöffel benutzte, als positive Elektrode einen Platindraht. So entdeckte er bei der Elektrolyse von geschmolzener caustischer Pottasche, also von Kaliumhydroxid, 1807 das Kalium. Wenig später erhielt er metallisches Natrium aus caustischer Soda. Diese Metalle fangen leicht Feuer oder laufen durch die Reaktion mit Luftsauerstoff an, und dementsprechend rief diese Entdeckung beträchtliche Aufregung und Interesse hervor. 1808 stellte Davy metallisches Magnesium, Calcium, Strontium und Barium her.[3]

Im Roman Metall von Karl Aloys Schenzinger wurden die historischen Persönlichkeiten der Elektrochemie in interessanter Form dargestellt.

Erforschung der grundlegenden Gesetzmäßigkeiten

[Bearbeiten | Quelltext bearbeiten]

Michael Faraday untersuchte ab 1832 die Elektrolyse genauer. Durch Wägung der abgeschiedenen Stoffmenge (Coulometer) nach einer bestimmten Zeitspanne konnte er die Elektrizitätsmenge (Ladungsmenge, Coulomb As) bei konstanter Spannung bestimmen. Nach ihm wurde später die Faraday-Konstante benannt, welche die Ladungsmenge und die abgeschiedene Stoffmenge in Relation setzt: zur Abscheidung von 1 Mol Stoff (z. B. Silber) ist eine Ladungsmenge von etwa 96485 Coulomb notwendig. Ist das abzuscheidende Ion mehrfach geladen, so muss die mehrfache Ladung des Ions mit einem ganzzahligen Vielfachen der entsprechenden Ladung berücksichtigt werden. Diese Abhängigkeiten der umgesetzten Massen von der Ladungsmenge und der Molmasse heißen heute Faradaysche Gesetze. Faraday stellte auch eine Tabelle über Kationen und Anionen zusammen. Außerdem schuf Faraday auch eine Reihe von Begriffen, die zur Beschreibung der Ergebnisse notwendig waren, wobei er von einem Philosophen und Mathematiker aus Cambridge, William Whewell, beraten wurde. So prägten sie die neuen Begriffe Elektrolyse, Elektrode, Elektrolyt, Anode, Kathode, Anion und Kation, veröffentlicht in Faradays Arbeit 1832/1834.

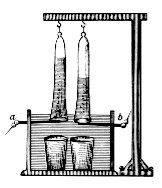

John Frederic Daniell tauchte 1835 ein Kupferblech in eine Kupfersulfatlösung und ein Zinkblech in eine Zinksulfatlösung. Beide Halbzellen trennte er durch ein Diaphragma (Tondiaphragma). Das Daniell-Element wurde nun für einige Jahre zur wichtigsten elektrischen Energiequelle. 1843 stellte Robert Bunsen eine sehr preiswerte Batterie mit einer Zinkplatte und einer speziellen Kohle in verdünnter Schwefelsäure her. Sie war bis zur Erfindung des Dynamos durch Werner von Siemens die beste Quelle für elektrischen Strom.

Charles Wheatstone entwickelte die Brückenschaltung zur Bestimmung von Widerständen, Johann Christian Poggendorff erfand die Poggendorffsche Kompensationsschaltung zur Ermittlung der Spannungen, Friedrich Kohlrausch entwickelte eine Methode zur Widerstandsmessung einer Elektrolytlösung ohne Polarisation der Elektroden mittels Wechselstrom, das Kohlrausches Quadratwurzelgesetz,[4] so dass nun Leitfähigkeiten von Elektrolytlösungen untersucht werden konnten.

Johann Wilhelm Hittorf, der 1853 seine elektrolytischen Studien[5] begann, erkannte die unterschiedlichen Wanderungsgeschwindigkeiten der Ionen bei einer Elektrolyse, er führte die Überführungszahl ein.[6] Friedrich Kohlrausch untersuchte die Leitfähigkeiten von konzentrierten bis stark verdünnten Salzlösungen und konnte durch graphisches Auftragen der Leitwerte und der Wurzel aus der Salzkonzentration einen linearen Zusammenhang feststellen. In hoher Verdünnung besitzt jedes Ion einen ganz charakteristischen Leitwert. Kohlrausch führte die Molare Leitfähigkeit ein.[7]

Svante Arrhenius und Wilhelm Ostwald untersuchten die Leitfähigkeiten von schwachen Säuren, Basen und Salzen in wässrigen Lösungen.[8] Aufbauend auf Erkenntnissen von Jacobus Henricus van ’t Hoff, dass der osmotische Druck und die Gefrierpunkterniedrigung einer Flüssigkeit proportional der Zahl der ionischen Einzelteilchen einer Lösung sind, entdeckten Arrhenius und Ostwald das Prinzip der Dissoziation von schwachen Säuren durch Leitfähigkeitsmessungen. Je nach Säurestärke liegt nur ein Teil der Säure in ionischer Form vor. Ostwald (1881) leitete ein Gesetz (Ostwaldsches Verdünnungsgesetz) zur Berechnung von Leitfähigkeiten in Abhängigkeit von Konzentration und Säurestärke ab.[9]

Im Jahr 1923 berechneten Petrus Debye, Erich Hückel und Lars Onsager die Wechselwirkung der Ionen mit der Dielektrizitätskonstanten der Lösung und konnten eine noch genauere mathematische Theorie der Leitfähigkeitsbestimmung vornehmen. Die Kenntnis der Dissoziation, der ionischen Leitfähigkeit in wässrigen Lösungen, war für die pH-Bestimmung, die Umsatzkontrolle von Elektrolysen, die Bestimmung des Salzgehaltes von Lösungen unbekannter Konzentration von großer Bedeutung.

Max Julius Le Blanc ermittelte die Spannungswerte (Zersetzungsspannung) zur Stoffabscheidung aus Normallösungen[10], fand eine Methode zur Ermittlung der einzelnen Elektrodenpotentiale[11] und führte auch eine oszilloskopische Strom-Zeit-Messung bei der Elektrolyse ein.[12]

Hermann von Helmholtz prägte auf Grundlage von elektrochemischen Arbeiten die Begriffe Energie, Freie Enthalpie (Reaktionstriebkraft, Wärmeentwicklung und Ordnungszustand nach einer chemischen Reaktion) und die Abhängigkeit eines Gleichgewichtes von der Temperatur.

Walther Nernst untersuchte die Elektrolytkonzentrationen bei Oxidations- und Reduktionsvorgängen und fand eine verständliche Erklärung für metallische Abscheidungen an der Kathode und die Auflösungen von Anodenmetallen.[13][14] Anhand der Elektrolytkonzentration mittels der Nernstgleichung ließen sich so Abscheidespannungen und auch elektrochemische Redoxgleichgewichte bestimmen.

Nernst gab der Halbzelle einer mit Wasserstoff umspülten Platinelektrode in 1-molarer Salzsäure, die im Gleichgewicht mit der Wasserstoffbildung steht, das willkürliche Standardnormalpotential 0 V. Auf diesem Bezugspunkt konnten nun alle Spannungswerte anderer Redoxgleichgewichte bestimmt werden und eine einheitliche elektrochemische Spannungsreihe aufgestellt werden. Auch bei der Erklärung von Diffusionsvorgängen war Nernst neben Cottrell ein Wegbereiter.[15][16][17]

Julius Tafel befasste sich mit der Überspannung (Elektrochemie) an Elektroden und entwickelte für diese eine mathematische Formulierung.[18]

Oliver Wolcott Gibbs und Alexander Classen entwickelten die Grundlagen zur qualitativen und quantitativen Stoffabscheidung von Metallionen in wässrigen Lösungen durch die Elektrogravimetrie.[19]

Technische Nutzung und Fortschritte der Theorie in der zweiten Hälfte des 19. Jahrhunderts

[Bearbeiten | Quelltext bearbeiten]

1851 erhielt C. Watt ein englisches Patent auf eine Zelle zur elektrolytischen Herstellung von Chlorat aus Salzlösung, die schon einige Merkmale heutiger Zellen aufwies. Da er allerdings noch keinen Dynamo zur Verfügung hatte, wurde es noch nicht genutzt; erst nach 1886 wurde Chlorat elektrosynthetisch hergestellt. Nach der Erfindung leistungsfähiger elektrischer Generatoren – die übrigens auch auf Arbeiten Michael Faradays beruhten –, neben anderen auch 1866 durch Werner von Siemens, der das dynamoelektrische Prinzip nutzte, führten dazu, dass elektrische Ströme preiswerter wurden. In den Jahren vor der Jahrhundertwende kam es daraufhin zu einer stürmischen Entwicklung technischer Elektrolysen: Ab 1870 wurde Kupfer elektrolytisch in Deutschland, Frankreich, England gewonnen. Emil Wohlwill machte im Jahr 1875 Verbesserungen bei der Kupfer-, Silber- und Gold-Raffination in der Norddeutschen Affinerie. Wichtige Standorte der Kupferproduktion in Deutschland waren Mansfeld, Oker und die Norddeutsche Affinerie (heute Aurubis AG) in Hamburg. Die Kupferraffination setzte in den Vereinigten Staaten ab 1892 ein. Im Jahr 1910 betrug die elektrolytische Kupferherstellung in den USA schon über 400.000 Tonnen.

1890 führte Hamilton Castner eine nach ihm benannte Zelle zur Elektrolyse von geschmolzenem Natriumhydroxid ein. Hierbei ist die zylindrische Kathode, die sich in der Mitte einer Anode aus Nickelrohr befindet, durch einen Eisendrahtnetzzylinder von der Anode getrennt. Eine Sammelglocke nimmt das entstehende Natrium auf.[20] 1892 erfanden Hamilton Castner in den USA und Karl Kellner in Österreich das Amalgamverfahren zur Chloralkali-Elektrolyse. Hierbei wird ausgenutzt, dass sich Natrium als Amalgam in einer Quecksilberkathode löst, während die Bildung von Wasserstoff an der Kathode durch die hohe Überspannung verhindert wird. Im Jahr 1890 wurde in der Chemischen Fabrik Elektron in Griesheim unter Leitung von Ignatz Stroof die erste Anlage zur Chlor-Alkali-Elektrolyse nach dem Diaphragmaverfahren gebaut. Bereits im Jahre 1908 konnten schon 50.000 Tonnen Natriumhydroxid nach diesem Verfahren erzeugt werden.[21]

Die ersten Arbeiten zur elektrolytischen Gewinnung von Aluminium wurden von Robert Bunsen und St. Claire-Deville geleistet.[22] 1886 entwickelten Paul Louis Toussaint Héroult und Charles Martin Hall aus Ohio eine Elektrolysemethode zur Gewinnung von Aluminium, die heute nach den Entdeckern Hall-Héroult-Prozess genannt wird und die Grundlage heutiger Verfahren ist. Schon zwei Jahre später wurden Firmen gegründet, die diese anwandten, und 1900 wurden bereits 80.000 Tonnen Aluminium elektrolytisch gewonnen. Das Verfahren nutzt geschmolzenen Kryolith, Nariumhexafluoroaluminat, in dem Aluminiumoxid gelöst wird, als Elektrolyten. Die Elektrolyse wird bei ca. 950 °C durchgeführt, wobei sich das Aluminium am Boden der Elektrolysezelle sammelt.

Aufschwung in der ersten Hälfte des 20. Jahrhunderts

[Bearbeiten | Quelltext bearbeiten]Die Produktion mit Hilfe von Elektrolyseverfahren zeigte bis zum Abschwung während des Zweiten Weltkrieges in vielen Fällen ein starkes Wachstum. Beispielsweise wurden 1940 in den USA über 600.000 Tonnen Chlor hergestellt. Auch Wasserstoffperoxid wurde damals elektrosynthetisch hergestellt, wobei Schwefelsäure elektrolysiert wurde. Es entstehen Peroxoschwefelsäure und Peroxodischwefelsäure bzw. ihre Salze, die mit Wasser zu Wasserstoffperoxid hydrolysiert werden können. Dieses Verfahren wurde aber ab 1945 durch chemische Herstellungsmethoden ersetzt.

Die in den vierziger Jahren einsetzende Entwicklung von Potentiostaten[23], die es gestatten, elektrochemische Untersuchungen einschließlich von Elektrolysen unter besser kontrollierten Bedingungen zu untersuchen, da die Vorgänge an der Gegenelektrode die Potentialmessung nicht beeinflussen, befruchtete die folgende Erforschung der Elektrodenvorgänge.

Verbesserungen und neue Synthesen in der zweiten Hälfte des 20. Jahrhunderts

[Bearbeiten | Quelltext bearbeiten]1968 wurden von Beer Elektroden aus beschichtetem Titan, beispielsweise mit Rutheniumdioxid, patentiert. Diese sogenannten „dimensionsstabilen Anoden“ wurden schnell zum Material der Wahl für die elektrolytische Chlorherstellung, da sie im Gegensatz zu Graphit, dessen Oberfläche nach und nach oxidiert und damit abgetragen wird, weniger Verschleiß zeigen. Ende der 1960er Jahre brachte DuPont unter dem Handelsnamen „Nafion“ Ionenaustauschermembranen aus voll fluoriertem Polymer auf den Markt, die eine ausgeprägte chemische Stabilität mit brauchbarer Leitfähigkeit verbanden. Dies ermöglichte die Entwicklung von Membranverfahren zur Elektrolyse. Die Elektrolyse mit dem Ziel der Chloratherstellung nahm in den letzten Jahrzehnten des 20. Jahrhunderts einen beträchtlichen Aufschwung, der auf der verstärkten Nachfrage nach Chlordioxid als faserschonendes und effektives Bleichmittel in der Papierindustrie beruhte. Da sich Chlordioxid nicht transportieren lässt, erfolgt die Herstellung von Chlorat und Chlordioxid meist vor Ort.

Die starke Nachfrage nach Nylon brachte in der Mitte der sechziger Jahre die Firma Monsanto dazu, ein elektrolytisches Verfahren zur Herstellung einer Vorstufe des zur Nylonherstellung benötigten Hexandiamins zu entwickeln: Die elektrolytische Synthese von Adiponitril (Hexandinitril) aus Acrylnitril (Propennitril). Dabei wird das Acrylnitril kathodisch reduziert, und unter Protonierung dimerisiert. Durch katalytische Hydrierung erhält man dann das gewünschte Hexandiamin.

Neueste Entwicklungen

[Bearbeiten | Quelltext bearbeiten]Elektrolysen wässriger Lösungen, bei denen an der Kathode kein Wasserstoff entsteht, sondern stattdessen Sauerstoff umgesetzt wird, benötigen deutlich kleinere Spannungen und können daher Energie sparen. Da der Sauerstoff in ausreichender Menge zur Kathode gebracht werden muss, sind spezielle Elektroden nötig, sogenannte Gasdiffusionselektroden. Ende 2003 nahm die Bayer AG in Brunsbüttel eine Salzsäureelektrolyseanlage mit Sauerstoffverzehrkathoden in Betrieb, die 20.000 Tonnen Chlor im Jahr produzieren kann.[24]

Datumsliste

[Bearbeiten | Quelltext bearbeiten]- 1789 – Adriaan Paets van Troostwijk und Jan Rudolph Deiman führten 1789 eine Elektrolyse des Wassers durch

- 1791 – Luigi Galvani berichtet „Über die Kräfte der Electricität bei der Muskelbewegung“

- 1791 – Alessandro Volta beginnt mit seinen Arbeiten zur Elektrizität

- 1799 – Alessandro Volta stellt seine Voltasche Säule fertig, die erste leistungsfähige Batterie

- 1800 – Volta berichtet in einem auf Französisch abgefassten Brief mit dem Titel „Über die Elektrizität, die durch den bloßen Kontakt leitender Substanzen verschiedener Art erregt wird“ an Sir Joseph Banks

- 1800 – William Cruickshank, Johann Wilhelm Ritter, William Nicholson und Anthony Carlisle führen erste Elektrolysen durch.

- 1802 – Hisinger und Jöns Jakob Berzelius stellen Chlorat auf elektrochemischem Weg aus Kochsalz her

- 1802 – William Cruickshank verbessert die Voltasche Säule, auch durch eine Serienfertigung

- 1807 – Humphry Davy stellt Natrium und Kalium her

- 1808 – Humphry Davy erhält Magnesium, Calcium, Strontium und Barium

- 1818 – Humphry Davy erhält durch Elektrolyse von Lithiumcarbonat Lithiummetall

- 1848 – Hermann Kolbe veröffentlicht seine Ergebnisse zur Elektrolyse von Valeriansäure (Pentansäure)

- 1849 – Hermann Kolbe berichtet über die Elektrolyse von weiteren organischen Verbindungen. Er stellt z. B. Ethan aus Essigsäure her; die Elektrolyse von Carbonsäuren zur Herstellung von Alkanen wird nach ihm Kolbe-Elektrolyse genannt.

- 1851 – C. Watt erhält ein englisches Patent auf eine Zelle zur elektrolytischen Herstellung von Chlorat

- 1855 – Robert Wilhelm Bunsen erhält durch Elektrolyse einer Lithiumchloridschmelze größere Mengen an Lithiummetall

- 1864 – Der amerikanische Chemiker Oliver Wolcott Gibbs (1822–1908) nutzt die Elektrolyse zur quantitativen Analyse: Er scheidet Kupfer oder Nickel elektrolytisch ab. Aus der Massenänderung der Elektrode lässt sich die Menge bzw. Konzentration des Metalls, z. B. Kupfer, bestimmen. Er begründet damit die Elektrogravimetrie.

- 1867 – Werner von Siemens stellt seinen Dynamo vor, mit dem eine effiziente Bereitstellung von elektrischer Energie möglich wird

- 1884–1887 – Svante Arrhenius entwickelt die Theorie der elektrolytischen Dissoziation

- 1885 – Breuer entwickelt ein Diaphragma

- 1886 – Henri Moissan entdeckt per Elektrolyse von in wasserfreier Flusssäure gelöstem Kaliumfluorid das Fluor

- 1886 – Charles Martin Hall aus Ohio und Paul Héroult entdecken ein Elektrolyseverfahren zur Herstellung von Aluminium, das nach ihnen Hall-Héroult-Prozess genannt wird.

- 1889 – Walther Nernst veröffentlicht in seiner Habilitation die nach ihm benannte Nernst-Gleichung, die die Konzentrationsabhängigkeit des Elektrodenpotentials beschreibt

- 1890 – in Griesheim wird die erste Chloralkali-Elektrolyse zur technischen Gewinnung von Natronlauge in Betrieb genommen

- 1891 – Max Julius Le Blanc (1865–1943) arbeitet zur Zersetzungsspannung von Elektrolyten

- 1890 – Hamilton Castner führt eine Zelle zur Elektrolyse von geschmolzenem Natriumhydroxid ein

- 1892 – Hamilton Castner und Karl Kellner melden unabhängig voneinander Patente für eine Quecksilberzelle zur Produktion von Natriumhydroxid an

- 1902 – Max Julius Le Blanc stellt Chrom elektrolytisch her

- 1968 – Henri Bernard Beer patentiert Elektroden aus beschichtetem Titan, diese verbessern die Elektrolysen zur Chlorherstellung

- 2003 – In Brunsbüttel wird mit einer Salzsäureelektrolyse die erste technische Elektrolyse mit Sauerstoffverzehrkathode in Betrieb genommen.

Einzelnachweise

[Bearbeiten | Quelltext bearbeiten]- ↑ Journal der Physik. 2, 1790, S. 130.

- ↑ Handbuch der Experimentellen Chemie, Sekundarbereich II, Aulis Verlag Deubner & Co. KG, Köln 1994, ISBN 3-7614-1630-X, S. 12 ff.

- ↑ A. F. Holleman, E. Wiberg, N. Wiberg: Lehrbuch der Anorganischen Chemie. 91.–100., verbesserte und stark erweiterte Auflage. Walter de Gruyter, Berlin 1985, ISBN 3-11-007511-3.

- ↑ Wied. Annalen 17, 642 (1882).

- ↑ Paul Diepgen, Heinz Goerke: Aschoff/Diepgen/Goerke: Kurze Übersichtstabelle zur Geschichte der Medizin. 7., neubearbeitete Auflage. Springer, Berlin/Göttingen/Heidelberg 1960, S. 35.

- ↑ Poggendorfsche Annalen 89,98,103,106 (1853,1859).

- ↑ Wied. Annalen 6, 1 (1879), 26, 213 (1885).

- ↑ Arrhenius, Zeitschrift für physikalische Chemie, 1, 631 (1887).

- ↑ Zeitschrift für physikalische Chemie, 2, 270 (1888).

- ↑ Zeitschrift für physikalische Chemie 8, 299 (1891).

- ↑ Zeitschrift für physikalische Chemie 12, 333 (1893).

- ↑ M. Le Blanc: Abhandlung der Bunsen Gesellschaft 3 (1910).

- ↑ Zeitschrift für physikalische Chemie 4, 129 (1889).

- ↑ Zeitschrift für physikalische Chemie 2, 617 (1888).

- ↑ Zeitschrift für physikalische Chemie 47, 52 (1907).

- ↑ F. G. Cottrell, Zeitschrift für physikalische Chemie 42, 385 (1903).

- ↑ H. Jahn, Zeitschrift für physikalische Chemie 26, 408 (1898).

- ↑ Zeitschrift für physikalische Chemie, 50, 641 (1905).

- ↑ W. Jansen: Handbuch der experimentellen Chemie – Sekundarbereich II, Aulis Verlag Deubner & Co. KG, Köln 1994, S. 26.

- ↑ A. F. Holleman, E. Wiberg, N. Wiberg: Lehrbuch der Anorganischen Chemie. 91.–100., verbesserte und stark erweiterte Auflage. Walter de Gruyter, Berlin 1985, ISBN 3-11-007511-3, S. 932.

- ↑ Bolko Flintjer: Handbuch der experimentellen Chemie – Sekundarstufe II, S. 308, Aulis Verlag Deubner & Co. KG, Köln 1994.

- ↑ Poggendorfs Ann. 92, Seite 648 (1854).

- ↑ A. Hickling: Studies in electrode polarisation. Part IV.-The automatic control of the potential of a working electrode. In: Transactions of the Faraday Society. 38. Jahrgang, 1942, S. 27–33, doi:10.1039/TF9423800027.

- ↑ J. Kintrup, Gasdiffusionselektroden in der Elektrolyse ( vom 21. Januar 2011 im Internet Archive)