روش گروهی پردازش دادهها

روش گروهی مدیریت دادهها (GMDH) یک خانواده از الگوریتمهای استقرایی است که برای مدلسازی ریاضی مجموعه دادههای چندمتغیره بهصورت کاملاً خودکار طراحی شده است. این روش به بهینهسازی ساختاری و پارامتری مدلها میپردازد.

GMDH در زمینه هایی مانند داده کاوی ، کشف دانش ، پیش بینی ، مدل سازی سیستم های پیچیده ، بهینه سازی و تشخیص الگو استفاده می شود. [۱] الگوریتمهای GMDH از یک فرآیند استقرایی استفاده میکنند که طی آن مدلهای چندجملهای بهصورت تدریجی پیچیدهتر میشوند و بهترین مدل با استفاده از یک معیار خارجی انتخاب میشود. بخش آخر [۲] شامل خلاصه ای از کاربردهای GMDH در دهه 1970 است.

این روش گاهی با نامهایی مانند شبکه عصبی پیشخور چندجملهای یا خودسازماندهی مدلها نیز شناخته میشود[۳] .اGMDH یکی از نخستین روشهای یادگیری عمیق است که در سال ۱۹۷۱ برای آموزش یک شبکه عصبی هشتلایه استفاده شد. [۴] [۵]

محتوای ریاضی

رگرسیون چند جمله ای

این بخش بر اساس این منبع نوشته شده است. [۶]

این مسئله عمومی مدلسازی آماری دادهها است: فرض کنید یک مجموعه داده شامل ، با n نقطه داریم. هر نقطه شامل مشاهدات و یک متغیر هدف y برای پیشبینی است. سوال این است که چگونه میتوان متغیر هدف را بر اساس این مشاهدات به بهترین شکل پیشبینی کرد؟

ابتدا مجموعه داده به دو بخش تقسیم میشود:

- مجموعه آموزشی: برای تنظیم پارامترهای بیشتر مدل استفاده میشود.

- مجموعه اعتبارسنجی: برای تعیین اینکه کدام پارامترها باید شامل شوند و چه زمانی باید فرآیند تنظیم متوقف شود.

ما نمیخواهیم همه این مدلهای چندجملهای را قبول کنیم، زیرا تعداد آنها بسیار زیاد است. برای انتخاب بهترین زیرمجموعه از این مدلها، هر مدل روی مجموعه اعتبارسنجی اجرا میشود و مدلهایی انتخاب میشوند که میانگین مربعات خطای (MSE) آنها کمتر از یک آستانه مشخص باشد. همچنین کمترین مقدار خطای به دست آمده به صورت ثبت میشود.

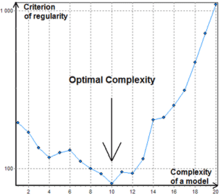

همان الگوریتم ادامه می یابد و مقادیر را تولید میکند. تا زمانی که هر کمتر از مقدار قبلی باشد، فرآیند ادامه پیدا میکند و مدلها به عمق بیشتری میرسند.به محض اینکه الگوریتم متوقف میشود. لایه آخر (لایه ) کنار گذاشته میشود، زیرا بیش از حد دادههای آموزشی را برازش کرده است، و لایههای قبلی به عنوان خروجی در نظر گرفته میشوند.

به طور فرض بعد از این عملیات، مجموعه ای شامل تا از مدل ها در دسترس باشد اکنون مدلها را مجموعه داده هایی گه باید مطابق ان اموز دیده شوند اجرا میکنیم تا دنبالهای از مشاهدات ایجاد شده را بهدست آوریم: . اکنون می توانیم همان الگوریتم را دوباره اجرا کنیم.

روشهای پیچیدهتری میتوانند برای تعیین زمان توقف استفاده شوند؛ مثلاً، الگوریتم را چند مرحله بیشتر ادامه میدهند تا از افزایش موقت عبور کنند.

به طور کلی

به جای استفاده از چندجملهای درجه دوم در دو متغیر، هر واحد میتواند چندجملهایهایی با درجه بالاتر و متغیرهای بیشتر به کار گیرد:

و به طور کلی تر:

که در آن:

- fi: توابع اولیه وابسته به ورودیهای مختلف

- ai: ضرایب

- m: تعداد اجزای تابع پایه

معیارهای خارجی اهداف بهینه سازی برای مدل هستند، مانند به حداقل رساندن میانگین مربعات خطا در مجموعه اعتبارسنجی، مهمترین معیارها عبارتند از:

- معیار منظمسازی (CR): کمینهسازی میانگین مربعات خطا روی مجموعه اعتبارسنجی.

- کمینهسازی خطا در مجموعه اعتبارسنجی متقابل.

- معیار حداقل سوگیری یا سازگاری: اختلاف مربعی خروجیهای تخمینی یا بردار ضرایب بین دو مدل، تقسیم بر مربع پیشبینیها بر روی یک مجموعه دیگر.

منابع

[ویرایش]- ↑ Madala, H.R.; Ivakhnenko, O.G. (1994). Inductive Learning Algorithms for Complex Systems Modeling. Boca Raton: CRC Press. ISBN 978-0849344381. Archived from the original on 2017-12-31. Retrieved 2019-11-17.

- ↑ Farlow, Stanley J. (November 1981). "The GMDH Algorithm of Ivakhnenko". The American Statistician (به انگلیسی). 35 (4): 210–215. doi:10.1080/00031305.1981.10479358. ISSN 0003-1305.

- ↑ Nikolaev, N.Y.; Iba, H. (March 2003). "Learning polynomial feedforward neural networks by genetic programming and backpropagation". IEEE Transactions on Neural Networks (به انگلیسی). 14 (2): 337–350. doi:10.1109/TNN.2003.809405. ISSN 1045-9227. PMID 18238017.

- ↑ Ivakhnenko, Alexey (1971). "Polynomial theory of complex systems" (PDF). IEEE Transactions on Systems, Man, and Cybernetics. SMC-1 (4): 364–378. doi:10.1109/TSMC.1971.4308320.

- ↑ Schmidhuber, Jürgen (2015). "Deep learning in neural networks: An overview". Neural Networks. 61: 85–117. arXiv:1404.7828. doi:10.1016/j.neunet.2014.09.003. PMID 25462637.

- ↑ Farlow, Stanley J. (November 1981). "The GMDH Algorithm of Ivakhnenko". The American Statistician (به انگلیسی). 35 (4): 210–215. doi:10.1080/00031305.1981.10479358. ISSN 0003-1305.