Erreur humaine

En psychologie, une erreur humaine est une action ou réponse inappropriée d'un être humain ou d'un groupe d’êtres humains qui entraîne ou pourrait entraîner un résultat non conforme à un attendu[1].

L'erreur humaine est considérée comme la cause la plus importante de désastres ou d'accidents mais aussi de la perte de performance des organisations. La prévention des erreurs humaines est généralement considérée comme un facteur majeur de fiabilité et de sécurité des systèmes (complexes). L'erreur humaine est l'une des nombreuses causes contributives des événements à risque. Ces éléments expliquent l'intérêt des chercheurs et des entreprises à comprendre et à adresser ce sujet.

L'erreur humaine est un domaine multidisciplinaire qui fait intervenir des experts des facteurs humains, des psychologues, et ergonomes pour la comprendre mais aussi des ingénieurs et des systémiciens pour en trouver les solutions.

Le terme même « erreur humaine » soulève des débats puisque certains comme Sénèque pensent que l'erreur est humaine par essence (il s'agirait donc d'une redondance) alors que d'autres soutiennent que l'erreur ne peut pas être humaine car sa cause est obligatoirement la conséquence d'un ensemble de paramètres extérieurs à lui dont il ne peut prendre en compte qu'une partie. Les autres débats sur le sujet concernent les classifications (taxonomie) des erreurs humaines ainsi que les approches pour les résoudre.

Définition

[modifier | modifier le code]Une erreur humaine est une action ou réponse inappropriée (involontaire, ou volontaire sans compréhension des impacts potentiels) d'un être humain ou d'un groupe d’êtres humains qui entraîne ou pourrait entraîner un résultat non conforme à un attendu (standard de performance)[1].

Selon Rasmussen[2] il est très difficile de donner une définition satisfaisante d'erreurs humaines.

L'appréhension du sujet varie en fonction de la culture[3] :

- En France, les erreurs remettent en cause les compétences;

- En Allemagne, erreur et faute se traduisent par un même mot : Fehler;

- Au Japon, l’erreur est une source d’amélioration continue... Etc...

Selon Reason[4],[5], il faudra parler d’ « erreurs » pour des actions planifiées (intentionnalité de l’action) qui n’atteignent pas l’objectif désiré car elles ne se déroulent pas en accord au plan ou car le plan lui-même est inadéquat pour atteindre l’objectif.

En gestion des risques, une erreur est un acte, une parole induisant un risque, un danger voire un accident ; lorsque l'acte est volontaire, on ne parle plus d'erreur mais de sabotage, d'acte criminel ou délictueux.

Importance du thème

[modifier | modifier le code]

L’erreur humaine est un phénomène intrinsèquement humain donc universel. Aux quatre coins de la planète et à tous moments des êtres humains génèrent des erreurs, tant dans leur vie privée que professionnelle.

Certaines de ces erreurs n’auront pas d’impacts ou des conséquences bénignes, d’autres auront de plus lourdes répercussions et seront à l’origine d’incidents, voire d’accidents graves et/ou mortels. Les exemples d'erreur humaine les plus cités sont ceux avec le plus d'impact humain ou environnemental. On peut citer: l'accident de Three Mile Island (Industrie nucléaire), les erreurs de pilotage, le désastre de la navette spatiale Challenger et la catastrophe de la navette spatiale Columbia, la catastrophe des Courrières, l'échouement du pétrolier Exxon Valdez au large de l'Alaska en 1989 ou encore les erreurs médicales. Plus anecdotique, mettre à la poubelle un billet de banque sans s'en rendre compte peut aussi être considéré comme une erreur humaine.

De même, les accidents de la route qui blessent gravement ou mortellement des personnes chaque mois par centaine (hécatombes) pendant des décennies sont le plus souvent attribués à des erreurs humaines ou des facteurs humains[6],[7],[8], les sources ne distinguant pas toujours les notions de facteur et d'erreur. Dans le «système sûr» (en anglais : Safe System Approach) l'infrastructure routière cherche à ce qu'une erreur humaine ne conduise pas à un accident, en réduisant le risque d'erreur et les conséquences de l'erreur[9],[10]. Toutefois les échecs humains peuvent être soit des erreurs humaines soit des violations délibérées[11]. «L’idée du «système sûr» est d’accepter l’erreur humaine mais de tout faire pour que l’erreur n’entraîne pas des décès ou des blessures graves.»[12].

Au-delà de ces cas aux conséquences les plus graves, il y a un autre effet des erreurs humaines qui interpelle les entreprises : l’impact sur la diminution de la performance ou l'augmentation des coûts. Exemples : retravail, retards, gaspillages, frais de garantie... Si le processus n'a pas été totalement suivi lors de la fabrication d'un produit, les lots doivent être éliminés, retravaillés ou revalidés. L'erreur humaine et la performance sont les deux faces d'une même médaille: les mécanismes de «l'erreur humaine» sont les mêmes que les mécanismes de «la performance humaine».

Toute performance éventuellement qualifiée comme «erreur» le sera rétrospectivement[13]. Donc les actions appelées plus tard «erreur humaine» font en réalité partie du spectre ordinaire du comportement humain et de sa performance. L'étude de la distraction dans la vie quotidienne fournit une vaste documentation et une catégorisation de ces aspects du comportement.

Ce qui est désigné "erreur", est dépendant de la culture, du lieu et de l'époque à laquelle elle se produit. Par exemple, certains actes sont vivement conseillés dans certaines cultures et pas du tout acceptés dans d'autres (l'éructation); la poignée de main est un geste commun de salutation, mais pour des raisons d'hygiène elle peut être très vivement déconseillée lors d'une pandémie (poignée de main); enfin, le type de vêtement porté pourrait être considéré comme une erreur en fonction de votre situation géographique, des conditions météorologiques ou de la culture.

Classifications des erreurs humaines

[modifier | modifier le code]Il existe de nombreuses façons de catégoriser l'erreur humaine[14],[15] :

- Soit par son caractère exogène ou endogène (c.-à-d. provenant de l'extérieur ou de l'intérieur de l'individu) [16]

- Soit par l'évaluation de la réponse par rapport à l'attendu [17] :

- erreur de détection de problème (voir également la théorie de la détection de signal)

- erreur de diagnostic de problème (voir aussi résolution de problème)

- erreur dans la planification et l'exécution des actions [18] (par exemple : dérapages ou erreurs d'exécution en opposition aux erreurs d'intention [19],[5])

- Soit en fonction du niveau d'analyse; par exemple, perceptif (p. ex. illusions d'optique), cognitif, de communication ou organisationnel

- Soit en fonction du type d'erreur de manipulation physique [20]

- "écarts" survenant lorsque l'action physique ne parvient pas à atteindre l'objectif planifié

- "fautes" impliquant un échec de la mémoire[Quoi ?]

- Soit en fonction du caractère actif (dans le sens d'immédiat) ou latent de l'erreur:

- erreur active : action physique observable qui change l'état de l'équipement, du système ou de l'installation, entraînant des conséquences indésirables immédiates.

- erreur humaine latente entraînant des faiblesses cachées liées à l'organisation ou des défauts d'équipement qui sont en sommeil; ces erreurs peuvent passer inaperçues au moment où elles se produisent, sans résultat apparent immédiat.

- Soit en fonction du niveau de dépendance à l'équipement - manque de vigilance en raison de l'hypothèse faite que les commandes matérielles ou les dispositifs de sécurité physique fonctionneront toujours.

- Soit l'intervention de l'équipe - manque de vigilance créé par l'interaction sociale (interpersonnelle) entre deux ou plusieurs personnes travaillant ensemble.

Classifications par cause racine

[modifier | modifier le code]Dans son analyse des erreurs humaines, James Reason part du principe qu’il y a à priori une « intention » d’agir. Il n’y a donc pas "d'intention" de faire une « erreur » car ce serait là un abus de langage qualifiant d’erreur un acte de sabotage.

Ceci amène à considérer qu’il n’y a d’erreur que si, et uniquement si, l’acte de départ est intentionnel et qu’il a donc un but, un objectif déclaré à atteindre. Dans ce cas, le terme « erreur » désigne exclusivement la non-atteinte de l’objectif.

Toujours selon Reason, il existe deux raisons fondamentales qui génèrent des erreurs :

- Les actions ne se sont pas déroulées comme prévu (non-respect de la procédure)

- Les actions n’ont pas abouti au résultat voulu (procédure inopérante)

Ceci rejoint le concept de Rasmussen qui désigne trois sources d’erreurs dans notre fonctionnement (Behaviour SRK) :

- Les erreurs liées au savoir-faire (Skills). Par exemple, les erreurs d'habitude telles qu'oublier de tourner à droite (comportement attendu) quand on a l'habitude de tourner à gauche tous les jours.

- Les erreurs liées aux règles ou procédures (Rules). Par exemple, l'application de procédures non conformes aux conditions rencontrées sur le terrain.

- Les erreurs liées à la connaissance (Knowledge). Par exemple, le manque de connaissances, d'éducation.

Classifications par effet

[modifier | modifier le code]L'effet (impact en anglais) dû à l'erreur peut être ou négatif (accidents, dommages…) ou positif (sérendipité, nouveauté, innovation inattendue).

L'effet, positif ou négatif, peut aussi être classifié en fonction de son intensité. Par analogie avec l'échelle de Richter pour les séismes, les conséquences d'une erreur peuvent être classées sur une échelle graduée depuis anodines jusque totalement catastrophiques ou innovation majeure, voire révolutionnaire.

En termes d'accidentologie, les statistiques révèlent que 90 % des accidents de la route sont liés à une erreur humaine[réf. nécessaire][21].

Origines des erreurs humaines

[modifier | modifier le code]Voici quelques exemples de causes de l'erreur humaine collectées dans une entreprise pharmaceutique européenne lors d'interviews d'opérateurs :

- la pression du temps ou des collègues

- les distractions et interruptions

- le multi-tâches, notamment pendant les périodes charnières du début et de la fin de journée

- des instructions vagues ou sujettes à interprétation

- la confiance excessive en raison de la routine par exemple

- les changements de procédure

- l'environnement physique (température, humidité...)

- la documentation non exacte ou non disponible

- le manque de formation ou une formation inadaptée

- le moral en berne, tristesse ou manque de motivation

- ou tout simplement la maladresse

De nombreuses erreurs ont pour cause le fonctionnement du cerveau. L'étude cognitive de l'erreur humaine est un domaine de recherche très actif, comprenant des travaux liés aux limites de la mémoire et de l'attention ainsi qu'aux stratégies de prise de décision telles que l'heuristique de disponibilité et autres biais cognitifs. Ces heuristiques et biais sont des stratégies utiles et souvent correctes, mais qui peuvent conduire à des schémas d'erreur systématiques.

Les malentendus en tant que sujet de communication humaine ont été étudiés dans l'analyse de la conversation, notamment comme l'examen des violations du principe coopératif.

Les études organisationnelles sur les erreurs ou les dysfonctionnements ont inclus des études sur la culture de sécurité.

Statistiques de causes des erreurs humaines

[modifier | modifier le code]Il est difficile d'obtenir des statistiques fiables sur le taux d'erreurs d'origine humaine en raison du flou de la définition mais aussi de la confidentialité de ces informations. Selon la société de service en ingénierie Altran qui a approfondi[Quoi ?][réf. nécessaire] ce sujet : 30 à 40 % des erreurs sont classées comme ayant une cause racine directement humaine. Il s'agit par exemple de problèmes dans la communication d'une consigne, une mauvaise compréhension de la situation. 20 à 30 % des erreurs ont pour cause racine une erreur humaine dont la source est un autre être humain : la documentation ou la formation n'ont pas la qualité suffisante pour réaliser le travail, l'organisation est trop complexe (les responsabilités sont mal définies), les processus changent trop souvent…

D'autres causes ne sont pas considérées comme humaines comme par exemple: une machine qui ne fonctionne pas comme prévu, une matière première qui ne répond pas aux critères de qualité, des mesures de paramètres qui ne sont pas exactes. voir la classification des 6M.[Quoi ?]

Approches pour éviter les erreurs

[modifier | modifier le code]Approche de l'analyse des risques

[modifier | modifier le code]Il est possible de réduire le risque d’erreurs humaines en utilisant des outils classiques de gestion des risques. Cette dernière consiste à identifier et évaluer les risques potentiels pouvant mettre en danger le bon déroulement d’un projet, d'un évènement ou d'une activité.

Les risques sont évalués en fonction de leur nature (santé, sécurité, qualité, performance…), et en considérant les paramètres suivants :

- La gravité de l’incident (impact)

- La probabilité d’apparition ou de reproduction (fréquence)

Il existe plusieurs outils d’analyse de risque dont l’AMDEC (Analyse des Modes de Défaillance, de leurs Effets et de leur Criticité) et l’HAZOP (HAZard and OPerability studies):

AMDEC: mode et criticité de défaillance

[modifier | modifier le code]L'analyse des modes de défaillance, de leurs effets et de leur criticité (AMDEC) est un sigle connu.

AMDEC est à l’origine destiné à la gestion de la qualité, et est souvent utilisé pour la gestion des risques sous forme d’un tableau. Sa valeur ajoutée s’exprime quand il est utilisé en amont d’un projet. Il doit être régulièrement mis à jour dès la détection d’une nouvelle erreur.

Phases de l’établissement d’un AMDEC en :

- Phase de préparation : Constituer des groupes de travail afin de fixer le périmètre et l’étude des risques. Surtout dans le cas des erreurs humaines, il faut veiller à avoir un groupe de personnes aux profils et aux rôles complémentaires.

- Analyse fonctionnelle : Réaliser un découpage fonctionnel et identifier les liens entre chaque composant. Dans le cas d’une erreur humaine, il s’agit de décomposer l’évènement ou l'activité en étapes afin d’identifier tous les paramètres intervenants dans l’erreur.

- Identification des problèmes, de leur criticité et des causes racines correspondantes. (Voir liste des causes racines potentielles)

- Détermination des actions correctives et priorisation en utilisant, par exemple, une matrice gains-efforts.

HAZOP: décomposition du risque en nœuds

[modifier | modifier le code]HAZOP est l'acronyme de HAZard and OPerability studies.

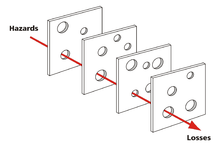

Le principe de HAZOP est la décomposition du système à analyser en plusieurs sous-ensembles, appelés « nœuds » afin que l’analyse des risques puisse être partagée entre des personnes ou des équipes multidisciplinaires.

Approche systémique

[modifier | modifier le code]Une erreur humaine correspond à trois critères

- L’existence d’une procédure (ou règle ou norme) et d'un objectif à atteindre (Reason, Rasmussen)

- Une déviance par rapport à l’objectif (savoir faire ou connaissance) (Reason, Rasmussen)

- La désignation en tant qu’erreur

L’approche systémique ne se départ pas des critères ci-dessus. Elle introduit néanmoins la notion d’interaction qui fait que l’erreur est à appréhender sous forme de manquement à la communication. L’interaction entre les éléments du système peut se révéler déficiente pour des raisons identiques à celle attribuées à l’erreur.

La communication entre les éléments du système peut échouer parce que les dits éléments ont des points de référence différents et donc mécomprennent le message reçu. La diversité des protagonistes est un facteur aggravant de la mécompréhension. Plus elle est grande, plus la communication peut être déficiente. Ceci se rapproche des notions de connaissances et savoir-faire qui sont considérées comme sources d'erreur.

De même, cette mécompréhension pour être catégorisée « erreur » doit être désignée comme telle et donc référer à la norme ou l’attente de celui qui la désigne, créant de la sorte une boucle de feedback entre les protagonistes. En qualifiant d’erreur l’acte de l’autre, j’induis un comportement qui peut être un renforcement de l’erreur (feedback positif).

La systémique va s’adresser non pas aux éléments du système mais bien aux interactions entre les éléments du système afin de réduire la différence normative et donc éviter les « erreurs » à travers un rééquilibrage de la communication. Il faut alors envisager le comment et non le pourquoi.

Une des questions fondamentales que la systémique va adresser sera celle du rôle de l’erreur dans l’interaction :

« L’erreur est une notion rétrospective, forgée par l’esprit à l’occasion d’une réflexion (l’erreur peut être qualifiée d’ « obstacle paradoxal » puisqu’elle nous aide à atteindre la vérité en nous trompant). » ref.

« Prendre un risque, c'est accepter de se donner un droit à l'erreur car l'échec est aussi lié à l'erreur, que Littré rapproche de l'illusion : «faute commise dans une supputation ». À l'inverse, prendre en compte et a priori l'erreur possible permettra sans doute de corriger la trajectoire de l'action engagée, par boucle d'informations récursive » - (Jean-François Hérouard)

L'approche systémique peut aussi être considérée comme une stratégie pour éviter l'Erreur fondamentale d'attribution qui consiste à négliger les facteurs externes au profit des facteurs internes.

Approche humaine

[modifier | modifier le code]

Approche intégrant les types de personnalités humaines avec le modèle de Reason Modèle du fromage suisse.

En considérant qu’il faut une approche à la fois systémique et systématique pour limiter le nombre de d’erreurs humaines, Christophe Oudot propose une approche multidisciplinaire articulée autour des 4 types de personnalité proposés par le psychanalyste Carl Gustav Jung et rendu connu par les outils comme le MBTI Myers Briggs type indicator ou l’insights discovery , HBDI...

Le déploiement d’une solution unique ne sera efficace que si on accepte la multiplicité des types de personnalités et donc des solutions. En mettant en parallèle une adaptation du modèle de Reason et le modèle de personnalités considérant les 2 axes : introvertis-extravertis et orientation action ou relation, 4 types de barrières peuvent être mises en place correspondant aux 4 types de personnalités:

- Des personnes plutôt extraverties, orientés vers la pensée et la tâche vont avoir besoin de solution très pragmatiques et souvent physiques. Exemple : une buttée qui empêche qu’une vanne soit tournée dans le mauvais sens ou une alarme qui se déclenche quand la porte d’un réfrigérateur reste ouverte trop longtemps. Il s’agit de barrières techniques, nommées détrompeurs ou Poka-Yoke Détrompeur en japonais.

- Des personnes plutôt introverties, orientée vers la pensée et la tâche vont avoir besoin de solution accompagnant l’action. Exemples : des procédures avec des actions détaillées, des listes de points de contrôle, des formations de terrain très concrètes. Il s’agit de barrières procédurales ou de systèmes de management ou de formations.

- Des personnes plutôt extraverties, orientées vers la relation et l’émotion vont avoir besoin de comprendre pourquoi une action est importante ou nécessaire. Il faudra qu’elles sentent qu’il y a une cohérence entre ce qui est demandé et leurs aspirations profondes. Exemples : attention portée à l’enthousiasme, à l’ambiance dans l’équipe, aux valeurs des individus, à l’intégration émotionnelle de la raison de réaliser des tâches. Il s’agit de barrières culturelles.

- Des personnes plutôt introverties, orientées vers la relation et l’émotion vont avoir besoin de pouvoir demander le point de vue ou l’aide de collègues. Exemples : activités réalisées en équipe, attention portée au stress ambiant, entretiens réguliers avec la ligne hiérarchique. Il s’agit de barrières collectives.

Les deux premières barrières sont basées sur l’analyse de cas passés, on parle de sécurité réglée. Les deux suivantes vont permettre d’anticiper des cas non prévus. La culture de la sécurité permettra de rapprocher ses barrières qui, mises en place de manière indépendantes ou éloignées n’ont pas l’effet escompté (page 10, Les facteurs humains et organisationnels de la sécurité, 2010).

Législation

[modifier | modifier le code]La législation européenne sur les machines[22] prévoit qu' «une erreur humaine raisonnablement prévisible au cours du fonctionnement n'entraîne pas de situation dangereuse»[23].

Controverses

[modifier | modifier le code]Controverses des chercheurs

[modifier | modifier le code]Certains chercheurs ont fait valoir que la dichotomie des actions humaines comme «correctes» ou «incorrectes» est une simplification excessive et néfaste d'un phénomène complexe[24],[25]. Mettre l'accent sur la variabilité de la performance humaine et la façon dont les opérateurs humains (et les organisations) peuvent gérer cette variabilité peut être une approche plus fructueuse. Les nouvelles approches, telles que l'ingénierie de la résilience mentionnée ci-dessus, mettent en évidence les rôles positifs que les humains peuvent jouer dans des systèmes complexes. Dans l'ingénierie de la résilience, les réussites (les choses qui vont bien) et les échecs (les choses qui ne vont pas) sont considérées comme ayant la même base, à savoir la variabilité des performances humaines.

Controverses de Homendy contre Biden

[modifier | modifier le code]D'après Homendy, les 94% d'erreur humaine sur la route ne seraient pas une erreur humaine, mais une prise de risque délibérée.

Voir aussi

[modifier | modifier le code]Bibliographie

[modifier | modifier le code]- Sebastian Dieguez, La force de nos bugs, Humensis, , 384 p. (lire en ligne)

Articles connexes

[modifier | modifier le code]- Fiabilité humaine

- Détrompeur physique

- Analyse des modes de défaillance, de leurs effets et de leur criticité (AMDEC)

- HAZOP

- Gestion des risques

- Evaluation des risques

- Raisonnement fallacieux

- L'erreur est humaine

Notes et références

[modifier | modifier le code]Notes

[modifier | modifier le code]Références

[modifier | modifier le code]- Senders, J.W. and Moray, N.P. (1991) Human Error: Cause, Prediction, and Reduction. Lawrence Erlbaum Associates, p.25. (ISBN 0-89859-598-3).

- (en) Rasmussen, Information processing and human-machine interaction, North-Holland, New York,

- « DROIT À L’ERREUR, ET SI L’ON S’INSPIRAIT D’AUTRES CULTURES ? », sur culturecourses.com, (consulté le ).

- Justin Larouzée, Franck Guarnieri, Denis Besnard, « Le modèle de l’erreur humaine de James Reason », sur hal-mines-paristech.archives-ouvertes.fr, .

- Reason, James (1990) Human Error. Cambridge University Press. (ISBN 0-521-31419-4).

- https://www.ncbi.nlm.nih.gov/pmc/articles/PMC8305933/

- https://highways.dot.gov/research/research-programs/safety/human-factors

- « Décès sur les routes en Europe : les chiffres (infographie) », sur europa.eu, (consulté le ).

- https://highways.dot.gov/public-roads/winter-2022/01

- (en) Abdulgafoor M. Bachani, Margie Peden, G. Gururaj, Robyn Norton et Adnan A. Hyder, « Road Traffic Injuries », dans Injury Prevention and Environmental Health., , 3e éd., livre (PMID 30212112, DOI 10.1596/978-1-4648-0522-6_ch3, lire en ligne).

- https://www.hse.gov.uk/humanfactors/topics/humanfail.htm

- (en) « EUR-Lex - 52018DC0293 », sur europa.eu (consulté le ).

- Woods, 1990

- Jones, 1999

- Wallace and Ross, 2006

- Senders and Moray, 1991

- Roth et al., 1994

- Sage, 1992

- Norman, 1988

- DOE HDBK-1028-2009 ( https://www.standards.doe.gov/standards-documents/1000/1028-BHdbk-2009-v1/@@images/file)

- Informations sur TF1

- directive relative aux machines

- (en) « EUR-Lex - 02006L0042-20091215 », sur europa.eu (consulté le ).

- Hollnagel, E. (1983). Human error. (Position Paper for NATO Conference on Human Error, August 1983, Bellagio, Italy)

- Hollnagel, E. and Amalberti, R. (2001). The Emperor’s New Clothes, or whatever happened to “human error”? Invited keynote presentation at 4th International Workshop on Human Error, Safety and System Development.. Linköping, June 11–12, 2001.