Վարիացիոն ինքնակոդավորիչ

| Ենթակատեգորիա | • Արհեստական նեյրոնային ցանց • Ինքնակոդավորիչ | |

|---|---|---|

| Հայտնաբերող կամ հնարող | Diederik P. Kingma, Մաքս Վելինգ | |

Մեքենայական ուսուցման մեջ վարիացիոն ինքնակոդավորիչը (VAE) արհեստական նեյրոնային ցանցի կառուցվածք է, որը ներկայացվել է Դիդերիկ Պ. Քինգմայի և Մաքս Ուելինգի կողմից։[1] Այն հավանականական գրաֆիկական մոդելների և բայեսյան վարիացիոն մեթոդների ընտանիքների մի մասն է։[2]

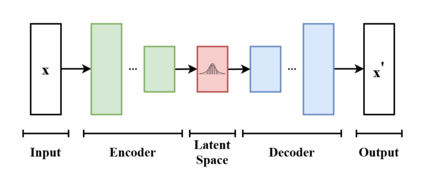

Բացի ինքնակոդավորիչ նեյրոնային ցանցի կառուցվածք դիտարկվելուց, վարիացիոն ինքնակոդավորիչները կարող են ուսումնասիրվել նաև բայեսյան վարիացիոն մեթոդների մաթեմատիկական ձևակերպման շրջանակներում՝ միացնելով նեյրոնային կոդավորիչի ցանցն իր ապակոդավորիչին հավանական լատենտ տարածության միջոցով (օրինակ՝ որպես բազմաչափ Գաուսի բաշխում) որը համապատասխանում է վարիացիոն բաշխման պարամետրերին։

Այսպիսով, կոդավորիչը մեծ համալիր տվյալներից յուրաքանչյուր կետը (օրինակ՝ պատկերը) բաշխում է լատենտ տարածության մեջ, այլ ոչ թե այդ տարածության մեկ կետի: Ապակոդավորիչն ունի հակառակ գործառույթը, այն է՝ լատենտ տարածությունից արտապատկերել մուտքային տարածություն՝ կրկին ըստ բաշխման (չնայած գործնականում վերծանման փուլում աղմուկը հազվադեպ է ավելացվում)։ Մեկ կետի փոխարեն բաշխման վրա արտապատկերելով՝ ցանցը կարող է խուսափել վերապատրաստման տվյալների վերաուսուցումից: Երկու ցանցերն էլ սովորաբար վերապատրաստվում են վերապարամետրացման հնարքի կիրառման հետ մեկտեղ, թեև աղմուկի մոդելի տարբերությունը կարելի է սովորել առանձին:

Չնայած մոդելի այս տեսակն ի սկզբանե նախատեսված էր չվերահսկվող ուսուցման համար,[3][4] դրա արդյունավետությունն ապացուցված է կիսավերահսկվող ուսուցման[5][6] և վերահսկվող ուսուցման համար։[7]

Ծանոթագրություններ

[խմբագրել | խմբագրել կոդը]- ↑ Kingma, Diederik P.; Welling, Max (2022-12-10). «Auto-Encoding Variational Bayes». arXiv:1312.6114 [stat.ML].

- ↑ Pinheiro Cinelli, Lucas; և այլք: (2021). «Variational Autoencoder». Variational Methods for Machine Learning with Applications to Deep Networks. Springer. էջեր 111–149. doi:10.1007/978-3-030-70679-1_5. ISBN 978-3-030-70681-4. S2CID 240802776.

- ↑ Dilokthanakul, Nat; Mediano, Pedro A. M.; Garnelo, Marta; Lee, Matthew C. H.; Salimbeni, Hugh; Arulkumaran, Kai; Shanahan, Murray (2017-01-13). «Deep Unsupervised Clustering with Gaussian Mixture Variational Autoencoders». arXiv:1611.02648 [cs.LG].

- ↑ Hsu, Wei-Ning; Zhang, Yu; Glass, James (December 2017). «Unsupervised domain adaptation for robust speech recognition via variational autoencoder-based data augmentation». 2017 IEEE Automatic Speech Recognition and Understanding Workshop (ASRU). էջեր 16–23. arXiv:1707.06265. doi:10.1109/ASRU.2017.8268911. ISBN 978-1-5090-4788-8. S2CID 22681625.

- ↑ Ehsan Abbasnejad, M.; Dick, Anthony; van den Hengel, Anton (2017). Infinite Variational Autoencoder for Semi-Supervised Learning. էջեր 5888–5897.

- ↑ Xu, Weidi; Sun, Haoze; Deng, Chao; Tan, Ying (2017-02-12). «Variational Autoencoder for Semi-Supervised Text Classification». Proceedings of the AAAI Conference on Artificial Intelligence (անգլերեն). 31 (1). doi:10.1609/aaai.v31i1.10966. S2CID 2060721.

- ↑ Kameoka, Hirokazu; Li, Li; Inoue, Shota; Makino, Shoji (2019-09-01). «Supervised Determined Source Separation with Multichannel Variational Autoencoder». Neural Computation. 31 (9): 1891–1914. doi:10.1162/neco_a_01217. PMID 31335290. S2CID 198168155.