Функції втрат для класифікації

У машинному навчанні та математичній оптимізації функції втрат для класифікації є обчислювальними функціями втрат, що представляють ціну, сплачену за неточність прогнозів у задачах класифікації (потрібно ідентифікувати до якої категорії належить конкретне спостереження).[1]

Дано як простір усіх можливих вхідних даних (зазвичай ), і як набір міток (можливих вихідних даних), типовою метою алгоритмів класифікації є пошук функції , яка найкраще прогнозує значення мітки для заданого входу .[2] Однак, через неповну інформацію, наявність шуму під час вимірювання, або ймовірнісні складові процесу, який досліджується, можливо для одного і того ж самого мати, як передбачення, різні .[3] В результаті, метою навчання є мінімізація очікуваних втрат (також відомих як ризик), визначених як

де — задана функція втрат і — функція густини ймовірності процесу, яка генерує дані. Еквівалентно цю функцію можна записати як

У рамках класифікації часто використовують функції втрат, трактовані виключно в термінах добутку справжньої мітки на передбачену мітку . Отже, їх можна визначити як функцію лише однієї змінної , таким чином з правильно обраною функцією . Вони називаються функціями втрат на основі маржі (margin-based loss functions). Вибір функції втрат на основі маржі прирівнюється до вибору . Обрання функції втрат у цій структурі впливає на оптимальну , яка мінімізує очікуваний ризик.

У разі бінарної класифікації можна спростити розрахунок очікуваного ризику за допомогою зазначеного вище інтегралу. Зокрема,

Друга рівність випливає з описаних вище властивостей. Третя рівність випливає з того факту, що 1 і −1 є єдино можливими значеннями для , а четверте — за рахунок Вираз у дужках відомий як очікуваний ризик.

Для мінімізатора можна вирішити проблему, взявши функціональну похідну від останньої рівності відносно , при цьому встановити похідну рівною 0. Це призведе до рівняння

що також є еквівалентним встановленню похідної від умовного ризику рівною нулю.

Враховуючи бінарну природу класифікації, природним відбором для функції втрат (припускаючи однакову вартість хибно позитивного та хибно негативного) буде функція втрат 0-1 (характеристична функція 0–1). Вона приймає значення 0, якщо прогнозована класифікація дорівнює класифікації істинного класу або 1, якщо прогнозована класифікація не відповідає істинному класу. Цей вибір моделюється за формулою

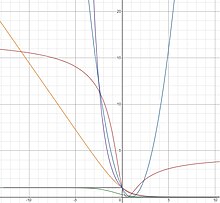

де позначає ступінчасту функцію Гевісайда. Однак, ця функція втрат є неопуклою і негладкою, і пошук оптимального рішення є NP-складною комбінаторною задачею оптимізації.[4] Як результат, краще розглянути сурогатні функції втрат, які підходять для часто вживаних алгоритмів навчання, оскільки вони мають і опуклі, і гладкі властивості. На додаток до їх обчислювальної керованості, можна показати, що вирішення проблеми навчання з використанням цих сурогатних функцій втрат дозволяють відновити фактичне вирішення вихідної проблеми класифікації.[5] Деякі з цих сурогатів описані нижче.

На практиці, розподіл ймовірностей є невідомим. Отже, використовуючи навчальний набір з незалежних та однаково розподілених точок вибірки

взятих з простору елементарних подій, ми прагнемо мінімізувати емпіричний ризик

як непрямий показник очікуваного ризику.[3] (Див. статистичну теорію навчання для більш детального опису.)

Використовуючи теорему Баєса, можна показати, що оптимальне , тобто те, що мінімізує очікуваний ризик пов'язаний із 0-1 втратою, реалізує правило оптимального рішення Байєса для проблеми бінарної класифікації та має форму

- .

Кажуть, що функція втрат є каліброваною за класифікацією або узгодженою за Баєсом, якщо її оптимальне є таким, що і, таким чином, є оптимальним за правилом Баєса. Узгоджена функція втрат Баєса дозволяє нам знайти функцію оптимального рішення Баєса шляхом безпосередньої мінімізації очікуваного ризику і без необхідності явного моделювання функцій густини ймовірності.

Для опуклої функції втрат маржі , можна показати, що є узгодженою за Баєсом тоді і тільки тоді, коли вона диференційована в 0 і .[6][1] Проте цей результат не виключає існування неопуклих та узгоджених за Байєсом функцій втрат. Більш загальний результат стверджує, що узгоджені функції втрат Баєса можна створити за допомогою наступної формулювання [7]

- ,

де — будь-яка інвертована функція така, що і — будь-яка диференційована строго угнута функція така, що . Таблиця-I демонструє створені узгоджені функції втрат Баєса для деяких прикладів і . Зверніть увагу, що функції втрат Savage і Tangent не є опуклими. Виявилося, що такі неопуклі функції втрат корисні для боротьби з промахами в класифікації.[7][8] Для всіх функцій втрат, породжених з (2), апостеріорну ймовірність можна знайти за допомогою функції зворотного звʼязку як . Функції втрат, де апостеріорна ймовірність може бути відновлена за допомогою інветнованого зв'язку, називаються власними функціями втрат.

| Назва функції втрат | ||||

|---|---|---|---|---|

| Експоненціальна | ||||

| Логістична | ||||

| Квадратна | ||||

| Savage | ||||

| Tangent |

Єдиний мінімізатор очікуваного ризику, , пов'язаний з вищезгаданими функціями втрат, можна безпосередньо знайти з рівняння (1) і показати, що він дорівнює відповідній . Це справедливо навіть для неопуклих функцій втрат і означає, що алгоритми на основі градієнтного спуску, такі як бустер градієнта[en], можна використовувати для побудови мінімізатора.

Для власних функцій втрат маржу можна визначити як і показати, що вона безпосередньо пов'язана з властивостями регуляризації класифікатора.[9] Зокрема, функція втрат з більшою маржою збільшує регуляризацію і дає кращі оцінки апостеріорної ймовірності. Наприклад, маржа втрат може бути збільшена для логістичних функцій втрат шляхом введення параметра і визначення функції як , де менший збільшує маржу втрат. Показано, що це прямо еквівалентно зменшенню швидкості навчання при градієнтному бустері[en] де зменшення параметру покращує регуляризацію посиленого класифікатора. Теорія чітко дає зрозуміти, що використання швидкості навчання зумовлює появу корректної формули для отримання апостеріорної ймовірності .

На закінчення, обравши функцію втрат з більшою маржою (меншим ), ми збільшуємо регуляризацію та покращуємо наші оцінки апостеріорної ймовірності, що, у свою чергу, покращує криву ROC кінцевого класифікатора.

Хоча квадратична функція втрат частіше використовується в регресії, її можна переписати як функцію і використовувати для класифікації. Квадратичну функцію можна створити за допомогою (2) і Таблиці-I наступним чином

Функція квадратичних втрат є як опуклою, так і гладкою. Однак, квадратична функція втрат має тенденцію надмірно штрафувати промахи, що призводить до повільніших показників збіжності (що стосується складності вибірки) порівняно з функціями логістичних або шарнірних втрат.[1] Крім того, функції, які дають високі значення для деяких будуть погано працювати з функцією квадратичних втрат, оскільки високі значення будуть суворо каратися, незалежно від того, чи співпадають ознаки у і .

Перевага функції квадратичних втрат полягає в тому, що її структура піддається легкій перехресній перевірці параметрів регуляризації. Спеціально для регуляризації Тихонова можна вирішити задачу для параметра регуляризації, використовуючи перехресну перевірку без виключення, за той самий час, що й для вирішення однієї проблеми.[10]

Мінімізатор для квадратичної функції втрат можна знайти безпосередньо з рівняння (1) як

Логістична функція втрат може бути отримана за допомогою (2) та таблиці-I наступним чином

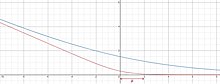

Логістична функція втрат є опуклою і зростає лінійно для від'ємних значень, що робить її менш чутливою до викидів. Логістичні втрати використовуються в LogitBoost алгоритмі[en].

Мінімізатор для логістичної функції втрат можна знайти безпосередньо з рівняння (1) як

Ця функція не визначена, коли або (що прямує до ∞ і −∞ відповідно), але передбачає плавну криву, яка зростає, коли росте і дорівнює 0, коли [3]

Легко перевірити, що логістична функція втрат та функція втрат від двійково перехресної ентропії (Log втрата) насправді однакові (до множення на константу ). Функція втрат від перехресної ентропії тісно пов'язана з розходженням Кульбака–Лейблера між емпіричним і прогнозованим розподілом. Перехресні втрати ентропії є широко розповсюдженими у сучасних глибоких нейронних мережах.

Експоненціальну функцію втрат можна згенерувати за допомогою (2) та таблиці-I наступним чином

Експоненціальна функція втрат є опуклою і зростає експоненціально для негативних значень, що робить її більш чутливою до викидів. Експоненціальна функція втрат використовується в AdaBoost алгоритмі[en].

Мінімізатор для експоненціальної функції втрат можна безпосередньо знайти з рівняння (1) як

Функцію втрат Savage[7] можна отримати за допомогою (2) та таблиці-I наступним чином

Функція втрат Savage є квазіопуклою і обмеженою для великих від'ємних значень, що робить її менш чутливою до викидів. Функція втрат Savage була використана для градієнтного бустера[en] та в алгоритмі SavageBoost.

Мінімізатор для функції втрат Savage можна безпосередньо знайти з рівняння (1) як

Тангенсну функцію втрат[11] можна отримати за допомогою (2) та таблиці-I наступним чином

Тангенсна функція втрат є квазіопуклою і обмеженою для великих від'ємних значень, що робить її менш чутливою до викидів. Цікаво, що тангенсна функція втрат також накладає обмежене покарання на точки, які були класифіковані як «занадто правильні». Це може допомогти у запобіганні перенавчанню набору даних. Тангенсна функція втрат використовується для градієнтного бустера[en], алгоритму TangentBoost та Alternating Decision Forests[12].

Мінімізатор для тангенсної функції втрат можна безпосередньо знайти з рівняння (1) як

Завісна функція втрат визначається за допомогою , де — додатня частина[en] функції.

Завісна функція втрат забезпечує відносно жорстку, опуклу верхню межу для характеристичної функції 0–1. Зокрема, завісна функція втрат дорівнює характеристичній функції 0–1, коли і . Крім того, емпірична мінімізація ризику цієї втрати еквівалентна класичному формулюванню для методу опорного вектора (SVM). Правильно класифіковані точки, що лежать за межами мержі опорних векторів, не штрафуються, тоді як точки в межах границь або на неправильній стороні гіперплощини штрафуються лінійно порівняно з їх відстанню до правильної межі.[4]

Хоча завісна функція втрат є як опуклою, так і безперервною, вона не є гладкою (не диференційованою) при . Отже, вона не може використовуватися з методами градієнтного спуску або методами стохастичного градієнтного спуску, які покладаються на диференційованість по всій області. Проте завісна функція втрат має субградієнт на , що дозволяє використовувати субградієнтні методи спуску.[4] SVM, які використовують завісну функцію втрат, також можна вирішити за допомогою квадратичного програмування .

Мінімізатор для завісної функції втрат визначається як

коли , що відповідає характеристичній функції 0–1. Цей висновок робить завісну функція втрат досить привабливою, оскільки можна встановити межі як різницю між очікуваним ризиком та знаком завісної функції втрат.[1] Завісну функція втрат не можна отримати з (2), оскільки не є оберненою.

Узагальнена плавна завісна функція втрат з параметром визначається як

де

Вона монотонно зростає і досягає 0, коли .

- ↑ а б в г Rosasco, L.; De Vito, E. D.; Caponnetto, A.; Piana, M.; Verri, A. (2004). Are Loss Functions All the Same? (PDF). Neural Computation. 16 (5): 1063—1076. doi:10.1162/089976604773135104. PMID 15070510.

- ↑ Shen, Yi (2005), Loss Functions For Binary Classification and Class Probability Estimation (PDF), University of Pennsylvania, процитовано 6 грудня 2014

- ↑ а б в Rosasco, Lorenzo; Poggio, Tomaso (2014), A Regularization Tour of Machine Learning, MIT-9.520 Lectures Notes, т. Manuscript

- ↑ а б в Piyush, Rai (13 вересня 2011), Support Vector Machines (Contd.), Classification Loss Functions and Regularizers (PDF), Utah CS5350/6350: Machine Learning, процитовано 4 травня 2021

- ↑ Ramanan, Deva (27 лютого 2008), Lecture 14 (PDF), UCI ICS273A: Machine Learning, процитовано 6 грудня 2014

- ↑ Bartlett, Peter L.; Jordan, Michael I.; Mcauliffe, Jon D. (2006). Convexity, Classification, and Risk Bounds. Journal of the American Statistical Association. 101 (473): 138—156. doi:10.1198/016214505000000907. ISSN 0162-1459. JSTOR 30047445.

- ↑ а б в Masnadi-Shirazi, Hamed; Vasconcelos, Nuno (2008). On the Design of Loss Functions for Classification: Theory, Robustness to Outliers, and SavageBoost (PDF). Proceedings of the 21st International Conference on Neural Information Processing Systems. NIPS'08. USA: Curran Associates Inc.: 1049—1056. ISBN 9781605609492.

- ↑ Leistner, C.; Saffari, A.; Roth, P. M.; Bischof, H. (September 2009). On robustness of on-line boosting - a competitive study. 2009 IEEE 12th International Conference on Computer Vision Workshops, ICCV Workshops: 1362—1369. doi:10.1109/ICCVW.2009.5457451. ISBN 978-1-4244-4442-7.

- ↑ Vasconcelos, Nuno; Masnadi-Shirazi, Hamed (2015). A View of Margin Losses as Regularizers of Probability Estimates. Journal of Machine Learning Research. 16 (85): 2751—2795. ISSN 1533-7928.

- ↑ Rifkin, Ryan M.; Lippert, Ross A. (1 травня 2007), Notes on Regularized Least Squares (PDF), MIT Computer Science and Artificial Intelligence Laboratory

- ↑ Masnadi-Shirazi, H.; Mahadevan, V.; Vasconcelos, N. (June 2010). On the design of robust classifiers for computer vision. 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition: 779—786. doi:10.1109/CVPR.2010.5540136. ISBN 978-1-4244-6984-0.

- ↑ Schulter, S.; Wohlhart, P.; Leistner, C.; Saffari, A.; Roth, P. M.; Bischof, H. (June 2013). Alternating Decision Forests. 2013 IEEE Conference on Computer Vision and Pattern Recognition: 508—515. doi:10.1109/CVPR.2013.72. ISBN 978-0-7695-4989-7.

![{\displaystyle I[f]=\displaystyle \int _{{\mathcal {X}}\times {\mathcal {Y}}}V(f({\vec {x}}),y)p({\vec {x}},y)\,d{\vec {x}}\,dy}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a681d2ec2b4e729a58045cd58dd718b1cc91b3d6)

![{\displaystyle {\begin{aligned}I[f]&=\int _{{\mathcal {X}}\times {\mathcal {Y}}}V(f({\vec {x}}),y)p({\vec {x}},y)\,d{\vec {x}}\,dy\\[6pt]&=\int _{\mathcal {X}}\int _{\mathcal {Y}}\phi (yf({\vec {x}}))p(y\mid {\vec {x}})p({\vec {x}})\,dy\,d{\vec {x}}\\[6pt]&=\int _{\mathcal {X}}[\phi (f({\vec {x}}))p(1\mid {\vec {x}})+\phi (-f({\vec {x}}))p(-1\mid {\vec {x}})]p({\vec {x}})\,d{\vec {x}}\\[6pt]&=\int _{\mathcal {X}}[\phi (f({\vec {x}}))p(1\mid {\vec {x}})+\phi (-f({\vec {x}}))(1-p(1\mid {\vec {x}}))]p({\vec {x}})\,d{\vec {x}}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b790a75d49d31c4d0b845445046bae07114894ee)

![{\displaystyle [\phi (f({\vec {x}}))p(1\mid {\vec {x}})+\phi (-f({\vec {x}}))(1-p(1\mid {\vec {x}}))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/976cb6e601d74f6154999611a9c8113ee189b6c4)

![{\displaystyle I[f]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8213b3ec4b7c34969992d3f12dd96b830c9082ef)

![{\displaystyle I_{S}[f]={\frac {1}{n}}\sum _{i=1}^{n}V(f({\vec {x}}_{i}),y_{i})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f11407df44b1dc610c3fe193ce436cc33520ffe5)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]\;\;\;\;\;(2)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7ba1d9d0d51b1c65272af55aa780a285afa90d9d)

![{\displaystyle {\frac {1}{\log(2)}}[-\eta \log(\eta )-(1-\eta )\log(1-\eta )]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e609e1c16646f7a8a99eb51b64fb94416a6a425)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=4({\frac {1}{2}}(v+1))(1-{\frac {1}{2}}(v+1))+(1-{\frac {1}{2}}(v+1))(4-8({\frac {1}{2}}(v+1)))=(1-v)^{2}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7cdde8f62987c985c1028a98d8c24682dfe0c2d7)

![{\displaystyle {\begin{aligned}\phi (v)&=C[f^{-1}(v)]+\left(1-f^{-1}(v)\right)\,C'\left[f^{-1}(v)\right]\\&={\frac {1}{\log(2)}}\left[{\frac {-e^{v}}{1+e^{v}}}\log {\frac {e^{v}}{1+e^{v}}}-\left(1-{\frac {e^{v}}{1+e^{v}}}\right)\log \left(1-{\frac {e^{v}}{1+e^{v}}}\right)\right]+\left(1-{\frac {e^{v}}{1+e^{v}}}\right)\left[{\frac {-1}{\log(2)}}\log \left({\frac {\frac {e^{v}}{1+e^{v}}}{1-{\frac {e^{v}}{1+e^{v}}}}}\right)\right]\\&={\frac {1}{\log(2)}}\log(1+e^{-v}).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4fd7a4c1188c935bcf5f76e4063f97034fb54e39)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=2{\sqrt {({\frac {e^{2v}}{1+e^{2v}}})(1-{\frac {e^{2v}}{1+e^{2v}}})}}+(1-{\frac {e^{2v}}{1+e^{2v}}})({\frac {1-{\frac {2e^{2v}}{1+e^{2v}}}}{\sqrt {{\frac {e^{2v}}{1+e^{2v}}}(1-{\frac {e^{2v}}{1+e^{2v}}})}}})=e^{-v}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aaf52f9ceb280f470317e416a711b1e924cc1bd0)

![{\displaystyle \phi (v)=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=({\frac {e^{v}}{1+e^{v}}})(1-{\frac {e^{v}}{1+e^{v}}})+(1-{\frac {e^{v}}{1+e^{v}}})(1-{\frac {2e^{v}}{1+e^{v}}})={\frac {1}{(1+e^{v})^{2}}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3bc29f01f367ef3f4d6f92ce2f91827622a59b30)

![{\displaystyle {\begin{aligned}\phi (v)&=C[f^{-1}(v)]+(1-f^{-1}(v))C'[f^{-1}(v)]=4(\arctan(v)+{\frac {1}{2}})(1-(\arctan(v)+{\frac {1}{2}}))+(1-(\arctan(v)+{\frac {1}{2}}))(4-8(\arctan(v)+{\frac {1}{2}}))\\&=(2\arctan(v)-1)^{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/48fc53108e779ecf1e26b0725b3873944fcd9644)

![{\displaystyle \phi (\upsilon )=\max(0,1-\upsilon )=[1-\upsilon ]_{+}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/068b33990cb9f189f89c1c4b775424ff8bd5fade)

![{\displaystyle [a]_{+}=\max(0,a)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/eb205e8d8fd29396410d5c3764b95f1323335f6e)

![{\displaystyle V(f({\vec {x}}),y)=\max(0,1-yf({\vec {x}}))=[1-yf({\vec {x}})]_{+}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bec5bd9d55a0fa201d877181b995db28b17f9827)