Bộ xử lý đồ họa

Bộ phận xử lý đồ họa (GPU, graphics processing unit) là một vi mạch chuyên dụng được thiết kế để thao tác và truy cập bộ nhớ đồ họa một cách nhanh chóng, đẩy nhanh việc tạo ra các hình ảnh trong bộ đệm khung hình (framebuffer) trước khi xuất ra màn hình hiển thị. GPU được sử dụng trong các hệ thống nhúng, điện thoại di động, máy tính cá nhân, máy trạm và máy chơi trò chơi điện tử video (console).

GPU hiện đại rất hiệu quả trong các thao tác đồ họa máy tính và xử lý hình ảnh. Kiến trúc song song ở mức độ cao làm cho nó hiệu quả hơn so với các CPU đa dụng vì việc xử lý một khối lượng lớn dữ liệu được thực hiện song song. Trong một máy tính cá nhân một GPU có thể nằm trên trên một bảng mạch rời, được nhúng trên bo mạch chủ, hoặc tích hợp trong một số CPU.[1]

Vào thập niên 70, ban đầu thuật ngữ "GPU" có nghĩa là "graphics processor unit", dùng để mô tả các bộ xử lý lập trình được, chúng hoạt động độc lập với CPU và đảm nhiệm các tác vụ đồ họa và xuất video.[2][3] Sau đó vào năm 1994, Sony sử dụng khái niệm "graphics processing unit" để gọi bộ xử lý đồ họa của Toshiba trong PlayStation.[4] Thuật ngữ này được đưa vào sử dụng phổ biến sau khi Nvidia quảng cáo GeForce 256 của mình là "GPU đầu tiên trên thế giới" vào năm 1999.[5][6] Một đối thủ cạnh tranh là ATI Technologies đưa ra một thuật ngữ khác là bộ phận xử lý hình ảnh (VPU, visual processing unit) sau khi phát hành Radeon 9700 vào năm 2002.[7]

Lịch sử

[sửa | sửa mã nguồn]Thập niên 1970

[sửa | sửa mã nguồn]Các bảng mạch hệ thống arcade sử dụng các mạch đồ họa chuyên dụng từ những năm 1970. Trong các phần cứng dành cho các trò chơi video đầu tiên, do giá thành cao của bộ đệm hình ảnh (thực chất là bộ nhớ RAM) nên các chip đồ hoạ chỉ tạo ra hình ảnh khi cùng lúc nó đang được vẽ lên màn hình.[8]

Một mạch barrel shifter đặc biệt được sử đụng để giúp CPU tạo ra hình ảnh động từ bộ đệm hình ảnh trong nhiều game arcade hồi thập niên 70 của Midway và Taito, như Gunfight (1975), Sea Wolf (1976), Space Invaders (1978).[9][10][11] Hệ thống arcade của Namco Galaxian sử dụng phần cứng đồ họa chuyên biệt hỗ trợ màu RGB, sprite đa sắc và hình nền tilemap.[12] Phần cứng Galaxian được sử dụng rộng rãi trong thời kỳ hoàng kim của arcade, bởi các công ty như Namco, Centuri, Gremlin, Irem, Konami, Midway, Nichibutsu, Sega và Taito.[13][14]

Ở thị trường gia đình, máy chơi trò chơi video Atari 2600 vào năm 1977 sử dụng một chip đơn giản có tên là TIA (Television Interface Adaptor).[15] Các máy tính 8 bit của Atari (1979) có ANTIC, một bộ xử lý video chuyên biệt, đọc vào các câu lệnh mô tả một "danh sách hiển thị" và sử dụng nó để xuất ra tín hiệu video phức tạp.[16][17][18]

Thập niên 1980

[sửa | sửa mã nguồn]

NEC µPD7220 là bộ xử lý đồ họa đầu tiên cho PC dưới dạng một chip VLSI duy nhất, cho phép các nhà sản xuất như Number Nine Visual Technology tạo ra các bảng mạch đồ họa với giá thành thấp và hiệu năng cao.[19] Đó có lẽ là GPU phổ biến nhất trong nửa đầu thập niên 80. Thiết kế của nó còn được cấp phép để sản xuất các chip khác như Intel 82720, bộ xử lý đồ họa đầu tiên của Intel.[20]

Năm 1983, Hitachi cho ra mắt ARTC HD63484, bộ xử lý đồ họa CMOS đầu tiên. ARTC có khả năng hiển thị hình ảnh 4K khi ở chế độ đơn sắc, và được sử dụng trong nhiều bảng mạch đồ họa của PC và trong các terminal đến cuối thập niên 80.[21] Vào năm 1985, máy tính cá nhân Commodore Amiga ra mắt với một bộ xử lý đặc biệt, bao gồm một phận bit blit (blit block transfer) để đẩy nhanh việc thay đổi bitmap, các hàm vẽ đường thẳng và tô tràn. Cùng với đó là một bộ đồng xử lý (co-processor) với tập lệnh riêng, cho phép thay đổi trực tiếp các thanh ghi phần cứng đồ họa mà không cần thông qua bộ xử lý trung tâm (CPU). Đến năm 1986, Texas Instruments ra mắt TMS34010, bộ xử lý có thể lập trình được đầu tiên dành cho đồ họa.[22] Nó có thể chạy các chương trình như một CPU thông thường, nhưng điểm nổi bật là tập lệnh hướng đồ họa. Trong khoảng thời gian 1990-1992, nhiều bo mạch đồ họa sử dụng TMS34010 với tiêu chuẩn đồ họa TIGA (Texas Instruments Graphics Architecture) được sử dụng để tăng tốc hệ điều hành Windows.

Năm 1987, IBM phát hành hệ thống đồ họa IBM 8514, sau khi giới thiệu tiêu chuẩn đồ họa Video Graphics Array (VGA).[23] Đó là một trong những tiêu chuẩn tăng tốc đồ họa 2D trong phần cứng đầu tiên của IBM PC.

1990 - 1999

[sửa | sửa mã nguồn]Năm 1991, S3 Graphics giới thiệu S3 86C911, được đặt theo tên của Porsche 911, hàm ý rằng nó mang lại cải thiện hiệu năng đáng kể.[24] 86C911 khai sinh ra một loại chip đồ họa mới, gọi là 2D accelerator. Vào khoảng 1995, hầu hết các nhà tạo chip đồ họa cho nền tảng PC đều sản xuất 2D accelerator.[25][26] Vào thời điểm này, các accelerator giá rẻ sử dụng phần cứng đã đạt đến hiệu năng của các bộ xử lý đồ họa đa năng.

Xuyên suốt thập niên 90, phần cứng 2D không ngừng phát triển. Với việc công nghệ sản xuất ngày càng cải thiện, các chip cũng được tích hợp nhiều hơn. Thêm vào đó là sự xuất hiện của các API đồ họa như WinG của Microsoft dành cho hệ điều hành Windows 3.x và DirectDraw dành cho các trò chơi trên nền tảng Windows 95 và sau này.

Trong khoảng nửa đầu của thập niên 90, đồ họa 3D thời gian thực trở nên phổ biến trong các trò chơi trên arcade, console và máy tính, dẫn đến nhu cầu đại chúng của các phần cứng 3D. Những ví dụ về phần cứng 3D được sản xuất hàng loạt đầu tiên bao gồm các arcade như Sega Model 1, Namco System 22 và Sega Model 2, hay các console như Sega Saturn, Playstation và Nintendo 64. Trong số đó có thể kể đến Reality Coprocessor của Nintendo 64 vào năm 1996; Fujitsu Pinolite, bộ xử lý hình học 3D đầu tiên cho máy tính cá nhân vào năm 1997[27]

Khái niệm "graphics processing unit" lần đầu tiên xuất hiện trong các tài liệu kỹ thuật về PlayStation của Sony vào năm 1994[28]

Đối với nền tảng PC, phải kể đến các trường hợp tiên phong nhưng thất bại của S3 ViRGE, ATI Rage, và Matrox Mystique. Các chip này cơ bản là các 2D accelerator với tính năng 3D được thêm vào sau. Ban đầu các phần cứng 3D mạnh chỉ bao gồm các chức năng đồ họa 3D và phải đi kèm với phần cứng 2D thông thường, như PowerVR và 3dfx Voodoo. Tuy nhiên, một khi công nghệ phát triển, tất cả các chức năng từ hiển thị đến 2D, 3D đều được tích hợp vào trong một chip duy nhất. Chipset Verite của Rendition là một trong những ví dụ đầu tiên thực hiện điều này thành công.

OpenGL xuất hiện vào đầu thập niên 90, là một API dành cho đồ họa chuyên nghiệp, tuy nhiên lại vấp phải các vấn đề về hiệu năng. Việc này tạo điều kiện để Glide API phát triển và trở thành tiêu chuẩn cho đồ họa PC vào cuối những năm 90. Tuy nhiên, những vấn đề của OpenGL nhanh chóng được giải quyết và Glide API dần bị đẩy ra rìa. Bên cạnh đó DirectX trở nên phổ biển trên nền tảng Windows.

2000 - 2010

[sửa | sửa mã nguồn]Với sự xuất hiện của Nvidia GeForce 8xxx và bộ phận xử lý luồng (stream processing unit) các GPU trở thành các thiểtt bị tính toán đa dạng hơn. Ngày nay, các GPU song song bắt đầu lấn sang lĩnh vực tính toán của các CPU, và một nhánh nghiên cứu ra đời, đó là tính toán GPU (GPGPU), có ứng dụng trong nhiều lĩnh vực đa dạng như học máy,[29] thăm dò dầu khí, xử lý hình ảnh khoa học, đại số tuyến tính,[30] thống kê,[31] tái dựng hình ảnh 3 chiều và thậm chí cả định giá quyền chọn cổ phiểu.

Nền tảng CUDA của Nvidia, lân đầu xuất hiện vào 2007,[32] là mô hình lập trình đầu tiên được dùng phổ biến trong tính toán GPU. Gần đây nhất OpenCL bắt đầu được hỗ trợ rộng rãi. OpenCL là một tiêu chuẩn mở bởi Kronos Group, cho phép phát triển phần mềm cho cả GPU và CPU.[33] Các giải pháp OpenCL được hỗ trợ bởi Intel, AMD, Nvidia và ARM.

2010 - nay

[sửa | sửa mã nguồn]Năm 2010 Nvidia hợp tác với Audi để sử dụng dòng GPU Tegra trong các dashboard của ô tô, cung cấp thêm tính năng cho các hệ thống dẫn đường và giải trí trong xe (infotainment).[34] Các tiến triển trong công nghệ GPU trong xe thúc đẩy công nghệ lái tự động.[35]

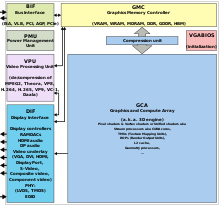

Chức năng tính toán

[sửa | sửa mã nguồn]Các GPU hiện đại sử dụng hầu hết các transistor của nó để thực hiện các tính toán liên quan đến đồ họa 3D. Ngoài phần cứng 3D ra, các GPU ngày nay còn có thêm phần cứng 2D và bộ đệm khung hình (framebuffer), thường là với một mode tương thích với VGA. Các GPU mới hơn có thể thiếu phần cứng 2D và sử dụng giả lập 2D trên phần cứng 3D. Ban đầu GPU được sử dụng để đẩy nhanh các tác vụ nặng trên bộ nhớ như texture-mapping và render các đa giác, sau đó mới thêm vào các bộ phận để tính nhanh các phép tính hình học như phép xoay, tịnh tiến các đỉnh vào các hệ tọa độ khác nhau. Các phát triển gần đây trên GPU bao gồm hỗ trợ các shader lập trình được, chúng có thể biến đổi các đỉnh và texture giống như cách người ta sử dụng các kỹ thuật nội suy, oversampling để làm giảm aliasing. Vì các phép tính toán này sử dụng nhiều vector và ma trận, các kỹ sư và nhà khoa học bắt đầu quan tâm đến việc sử dụng GPU cho các tính toán không phải là đồ họa; chúng rất phù hợp vơi các bài toán song song hoàn toàn (embarassingly parallel).

Vài yếu tố trong cấu thành của một GPU ảnh hưởng đến hiệu suất của nó trong việc kết xuất thời gian thực (real time rendering). Các yếu tố thưòng gặp bao gồm kích thước của tiến trình bán dẫn, tần số dao động của xung nhịp và số lượng cũng kích thước của bộ nhớ cache trên chip. Hiệu năng của một GPU được tính bằng số phép toán dấu phẩy động trong một giây (FLOPS), và các GPU trong giai đoạn 2010-2020 thường đạt đến mức tera-flops.[36]

Với sự ra đời của học sâu (deep learning), tầm quan trọng của GPU được tăng lên. Theo nghiên cứu thực hiện bởi Indigo, khi huấn luyện các mạng neuron học sâu, sử dụng GPU sẽ nhanh gấp 250 so với sử dụng CPU. Đã có những cạnh tranh nhất định trong lĩnh vực này với các ASIC, điển hình như bộ xử lý tensor (TPU) của Google, nhưng GPU vẫn có lợi thế vì nó có thể lập trình được.

Phân loại

[sửa | sửa mã nguồn]Có hai dạng GPU chính:

- GPU tích hợp - integrated GPU (IGP), hay còn gọi là shared/unified memory architecture (UMA)

- GPU rời - discrete GPU, hay còn gọi là dedicated GPU

Bảng mạch đồ họa rời

[sửa | sửa mã nguồn]Các GPU loại mạnh nhất thường giao tiếp với bảng mạch chủ thông qua các khe cắm mở rộng (expansion slot) như PCI Express (PCIe) hoặc Accelerated Graphics Port (AGP) và thường có thể được thay thế hay nâng cấp một cách tuơng đối dễ dàng.

Một GPU rời không nhất thiết phải tháo ra được, hay phải giao tiếp với mạch chủ theo một cách thông thường. GPU rời có đặc điểm là hệ thống cung cấp bộ nhớ dành riêng cho các GPU này. Hơn nữa, bộ nhớ này thường là loại được thiết kế dành riêng cho mạch đồ họa (xem thêm GDDR). GPU rời trong các máy tính xách tay thường sử dụng các giao diện không phải chuẩn do giới hạn về kích cỡ và khối lượng của thiết bị. Tuy nhiên, trên phương diện phần mềm thì chúng vẫn là PCIe hoặc AGP.

GPU tích hợp

[sửa | sửa mã nguồn]

Các GPU lớp này sử dụng một phần của bộ nhớ hệ thống. Chúng thường được tích hợp vào bảng mạch chủ trong các chipset (northbridge)[37] hoặc trong die của CPU. Chúng xuất hiện trên thị trường dưới tên APU (AMD) hay Intel HD Graphics. Kể từ đầu năm 2007, các máy tính sử dụng GPU tích hợp (IGP) chiếm đến 90% tổng số PC trên thị trường.[38][Cần cập nhật] Các IGP thường có chi phí sản xuất thấp và hiệu năng kém hơn so với các GPU rời. Trước đây, GPU tích hợp được cho là không đủ mạnh để chơi các trò chơi 3D hay chạy các chương trình sử dụng nhiều đồ họa, nhưng thực thi được các tác vụ bình thường như chạy một chuơng trình Adobe Flash. Tuy nhiên các IGP gần đây như Intel HD Graphics hay APU đủ mạnh để xử lý đồ họa 2D hoặc đồ họa 3D cấu hình thấp.

Xử lý dòng chảy (Stream processing) và GPU đa năng (GPGPU)

[sửa | sửa mã nguồn]Việc sử dụng các GPU đa năng (GPGPU) như một bộ xử lý dòng chảy (hoặc bộ xử lý vectơ) để chạy các compute kernel ngày càng trở nên phổ biến. Ý tưởng này biến sức mạnh tính toán khổng lồ của GPU hiện đại thành sức mạnh tính toán có mục đích chung, thay vì chỉ để thực hiện các tác vụ đồ họa. Trong một số ứng dụng nhất định đòi hỏi lượng phép toán vectơ khổng lồ, điều này có thể mang lại hiệu suất cao hơn vài bậc so với CPU thông thường. Hai nhà thiết kế GPU rời lớn nhất (xem phần "Cạc đồ họa chuyên dụng" ở trên), AMD và Nvidia, đang bắt đầu theo đuổi cách tiếp cận này với một loạt các ứng dụng. Cả Nvidia và AMD đều đã hợp tác với Đại học Stanford để tạo ra một ứng dụng khách dựa trên GPU cho dự án điện toán phân tán Folding@home, phục vụ cho các phép tính gấp protein. Trong một số trường hợp nhất định, GPU tính toán nhanh hơn bốn mươi lần so với các CPU trong cùng ứng dụng.[39][40]

GPGPU có thể được sử dụng cho nhiều tác vụ song song hoàn toàn như ray tracing. Chúng thường phù hợp với các kiểu phép tính thông lượng cao với dữ liệu song song để khai thác kiến trúc SIMD vectơ rộng của GPU.

Hơn nữa, các máy tính hiệu suất cao dựa trên GPU đang bắt đầu đóng một vai trò quan trọng trong việc tạo mô hình quy mô lớn. Ba trong số 10 siêu máy tính mạnh nhất trên thế giới tận dụng khả năng tăng tốc của GPU.[41]

GPU hỗ trợ các phần mở rộng API cho ngôn ngữ lập trình C như OpenCL và OpenMP. Hơn nữa, mỗi nhà cung cấp GPU giới thiệu API của riêng mình, chỉ hoạt động với card của họ: AMD APP SDK và CUDA của AMD và Nvidia. Các công nghệ này cho phép các hàm định sẵn, gọi là compute kernel từ một chương trình C thông thường để chạy trên bộ xử lý dòng của GPU. Điều này giúp các chương trình C có thể tận dụng khả năng của GPU để thao tác song song trên các bộ đệm lớn, trong khi vẫn sử dụng CPU khi thích hợp. CUDA cũng là API đầu tiên cho phép các ứng dụng dựa trên CPU truy cập trực tiếp vào tài nguyên của GPU để tính toán cho mục đích chung hơn mà không bị giới hạn bởi việc sử dụng API đồ họa.[cần dẫn nguồn]

Kể từ năm 2005, người ta đã quan tâm đến việc sử dụng hiệu suất được cung cấp bởi GPU để tính toán tiến hóa nói chung và để đẩy nhanh đánh giá độ phù hợp trong lập trình di truyền nói riêng. Hầu hết các cách tiếp cận đều biên dịch các chương trình dạng cây hoặc tuyến tính trên PC chủ và chuyển tệp thực thi sang GPU để chạy. Thông thường, lợi thế về hiệu suất chỉ có được khi chạy chương trình hoạt động duy nhất đồng thời trên nhiều bài toán mẫu một cách song song, sử dụng kiến trúc SIMD của GPU.[42][43] Tuy nhiên, cũng có thể đạt được khả năng tăng tốc đáng kể bằng cách không biên dịch các chương trình mà thay vào đó chuyển chúng sang GPU để diễn dịch.[44][45] Sau đó có thể tăng tốc bằng cách diễn dịch nhiều chương trình đồng thời hoặc chạy đồng thời nhiều bài toán mẫu, hoặc kết hợp cả hai cách. Một GPU hiện đại có thể diễn dịch đồng thời hàng trăm nghìn chương trình rất nhỏ một cách dễ dàng.

Một số GPU máy trạm hiện đại, chẳng hạn như Nvidia Quadro sử dụng kiến trúc Volta và Turing, có các lõi xử lý dành riêng cho các ứng dụng học sâu dựa trên tensor. Trong loạt GPU hiện tại của Nvidia, các lõi này được gọi là Lõi Tensor.[46] Các GPU này thường có hiệu suất FLOPS tăng đáng kể, sử dụng phép nhân và chia ma trận 4x4, dẫn đến hiệu suất phần cứng lên đến 128 TFLOPS trong một số ứng dụng.[47] Các lõi tensor này cũng được cho là xuất hiện trong dòng sản phẩm người tiêu dùng sử dụng kiến trúc Turing và có thể trong dòng sản phẩm người tiêu dùng Navi của AMD.[48]

Xem thêm

[sửa | sửa mã nguồn]- Texture mapping unit (TMU)

- Render output unit (ROP)

- Tấn công vét cạn

- Phần cứng

- Màn hình

- GPU cache

- GPU virtualization

- Bộ xử lý đa lõi

- Physics processing unit (PPU)

- Tensor processing unit (TPU)

- Phần cứng raytracing

- Software rendering

- Vision processing unit (VPU)

- Vector processor

- Video card

- Video display controller

- Video game console

- AI accelerator

- GPU Vector Processor internal features

Phần cứng

[sửa | sửa mã nguồn]- List of AMD graphics processing units

- List of Nvidia graphics processing units

- List of Intel graphics processing units

- Intel GMA

- Larrabee

- Nvidia PureVideo - the bit-stream technology from Nvidia used in their graphics chips to accelerate video decoding on hardware GPU with DXVA.

- SoC

- UVD (Unified Video Decoder) – the video decoding bit-stream technology from ATI to support hardware (GPU) decode with DXV

API

[sửa | sửa mã nguồn]- OpenGL API

- DirectX Video Acceleration (DxVA) API dành cho Microsoft Windows.

- Mantle (API)

- Vulkan (API)

- Video Acceleration API (VA API)

- VDPAU (Video Decode and Presentation API dành cho Unix)

- X-Video Bitstream Acceleration (XvBA), phiên bản của DXVA trên X-11 dành cho MPEG-2, H.264, và VC-1

- X-Video Motion Compensation – phiên bản trên X-11 dành cho MPEG-2 video codec only

Ứng dụng

[sửa | sửa mã nguồn]- GPU cluster

- Mathematica – hỗ trợ có sẵn cho cả CUDA và OpenCL

- Molecular modeling on GPU

- Deeplearning4j – học sâu phân tán, mã nguồn mở cho Java

Tham khảo

[sửa | sửa mã nguồn]- ^ Denny Atkin. “Computer Shopper: The Right GPU for You”. Bản gốc lưu trữ ngày 6 tháng 5 năm 2007. Truy cập ngày 15 tháng 5 năm 2007.

- ^ Barron, E. T.; Glorioso, R. M. (tháng 9 năm 1973). “A micro controlled peripheral processor”. MICRO 6: Conference Record of the 6th Annual Workshop on Microprogramming. Micro 6: 122–128. doi:10.1145/800203.806247. ISBN 9781450377836. S2CID 36942876.

- ^ Levine, Ken (tháng 8 năm 1978). “Core standard graphic package for the VGI 3400”. ACM SIGGRAPH Computer Graphics. 12 (3): 298–300. doi:10.1145/965139.807405.

- ^ Lỗi chú thích: Thẻ

<ref>sai; không có nội dung trong thẻ ref có têngpu2 - ^ “NVIDIA Launches the World's First Graphics Processing Unit: GeForce 256”. Nvidia. ngày 31 tháng 8 năm 1999. Bản gốc lưu trữ ngày 12 tháng 4 năm 2016. Truy cập ngày 28 tháng 3 năm 2016.

- ^ “Graphics Processing Unit (GPU)”. Nvidia. Truy cập ngày 29 tháng 3 năm 2016.

- ^ Pabst, Thomas (ngày 18 tháng 7 năm 2002). “ATi Takes Over 3D Technology Leadership With Radeon 9700”. Tom's Hardware. Truy cập ngày 29 tháng 3 năm 2016.

- ^ Hague, James (10 tháng 9 năm 2013). “Why Do Dedicated Game Consoles Exist?”. Programming in the 21st Century. Bản gốc lưu trữ ngày 4 tháng 5 năm 2015. Truy cập ngày 11 tháng 11 năm 2015.

- ^ “mame/8080bw.c at master 路 mamedev/mame 路 GitHub”. GitHub. Bản gốc lưu trữ ngày 21 tháng 11 năm 2014.

- ^ “mame/mw8080bw.c at master 路 mamedev/mame 路 GitHub”. GitHub. Bản gốc lưu trữ ngày 21 tháng 11 năm 2014.

- ^ “Arcade/SpaceInvaders – Computer Archeology”. computerarcheology.com. Bản gốc lưu trữ ngày 13 tháng 9 năm 2014.

- ^ “mame/galaxian.c at master 路 mamedev/mame 路 GitHub”. GitHub. Bản gốc lưu trữ ngày 21 tháng 11 năm 2014.

- ^ “mame/galaxian.c at master 路 mamedev/mame 路 GitHub”. GitHub. Bản gốc lưu trữ ngày 21 tháng 11 năm 2014.

- ^ “MAME - src/mame/drivers/galdrvr.c”. archive.org. Bản gốc lưu trữ ngày 3 tháng 1 năm 2014.

- ^ Springmann, Alessondra. “Atari 2600 Teardown: What?s Inside Your Old Console?”. The Washington Post. Lưu trữ bản gốc ngày 14 tháng 7 năm 2015. Truy cập ngày 14 tháng 7 năm 2015.

- ^ “What are the 6502, ANTIC, CTIA/GTIA, POKEY, and FREDDIE chips?”. Atari8.com. Bản gốc lưu trữ ngày 5 tháng 3 năm 2016.

- ^ Wiegers, Karl E. (tháng 4 năm 1984). “Atari Display List Interrupts”. Compute! (47): 161. Lưu trữ bản gốc ngày 4 tháng 3 năm 2016.

- ^ Wiegers, Karl E. (tháng 12 năm 1985). “Atari Fine Scrolling”. Compute! (67): 110. Lưu trữ bản gốc ngày 16 tháng 2 năm 2006.

- ^ F. Robert A. Hopgood; Roger J. Hubbold; David A. Duce biên tập (1986). Advances in Computer Graphics II. Springer. tr. 169. ISBN 9783540169109.

Perhaps the best known one is the NEC 7220.

- ^ Famous Graphics Chips: NEC µPD7220 Graphics Display Controller (IEEE Computer Society)

- ^ GPU History: Hitachi ARTC HD63484. The second graphics processor. (IEEE Computer Society)

- ^ “Famous Graphics Chips: TI TMS34010 and VRAM. The first programmable graphics processor chip | IEEE Computer Society”.

- ^ “The 8514/A Graphics Accelerator”. OS/2 Museum. 9 tháng 5 năm 2013. Truy cập ngày 19 tháng 6 năm 2014.

- ^ “S3 Video Boards”. InfoWorld. 14 (20): 62. 18 tháng 5 năm 1992. Lưu trữ bản gốc ngày 22 tháng 11 năm 2017. Truy cập ngày 13 tháng 7 năm 2015.

- ^ “What the numbers mean”. PC Magazine. 12: 128. 23 tháng 2 năm 1993. Lưu trữ bản gốc ngày 11 tháng 4 năm 2017. Truy cập ngày 29 tháng 3 năm 2016.

- ^ Singer, Graham. “The History of the Modern Graphics Processor”. Techspot. Lưu trữ bản gốc ngày 29 tháng 3 năm 2016. Truy cập ngày 29 tháng 3 năm 2016.

- ^ “Fujitsu Develops World's First Three Dimensional Geometry Processor”. fujitsu.com. Lưu trữ bản gốc ngày 12 tháng 9 năm 2014.

- ^ “Is it Time to Rename the GPU? | IEEE Computer Society”.

- ^ Raina, Rajat; Madhavan, Anand; Ng, Andrew Y. (14 tháng 6 năm 2009). “Large-scale deep unsupervised learning using graphics processors”. Proceedings of the 26th Annual International Conference on Machine Learning - ICML '09. Dl.acm.org. tr. 1–8. doi:10.1145/1553374.1553486. ISBN 9781605585161. S2CID 392458.

- ^ "Linear algebra operators for GPU implementation of numerical algorithms", Kruger and Westermann, International Conf. on Computer Graphics and Interactive Techniques, 2005

- ^ "ABC-SysBio—approximate Bayesian computation in Python with GPU support", Liepe et al., Bioinformatics, (2010), 26:1797-1799 “Archived copy”. Bản gốc lưu trữ ngày 5 tháng 11 năm 2015. Truy cập ngày 15 tháng 10 năm 2010.Quản lý CS1: bản lưu trữ là tiêu đề (liên kết)

- ^ Sanders, Jason; Kandrot, Edward (19 tháng 7 năm 2010). CUDA by Example: An Introduction to General-Purpose GPU Programming, Portable Documents (bằng tiếng Anh). Addison-Wesley Professional. ISBN 9780132180139. Lưu trữ bản gốc ngày 12 tháng 4 năm 2017.

- ^ “OpenCL - The open standard for parallel programming of heterogeneous systems”. khronos.org. Lưu trữ bản gốc ngày 9 tháng 8 năm 2011.

- ^ Teglet, Traian (8 tháng 1 năm 2010). “NVIDIA Tegra Inside Every Audi 2010 Vehicle”. Lưu trữ bản gốc ngày 4 tháng 10 năm 2016. Truy cập ngày 3 tháng 8 năm 2016.

- ^ “School's in session — Nvidia's driverless system learns by watching” (bằng tiếng Anh). 30 tháng 4 năm 2016. Lưu trữ bản gốc ngày 1 tháng 5 năm 2016. Truy cập ngày 3 tháng 8 năm 2016.

- ^ Hruska, Joel (10 tháng 2 năm 2021). “How Do Graphics Cards Work?”. Extreme Tech. Truy cập ngày 17 tháng 7 năm 2021.

- ^ “Evolution of Intel Graphics: I740 to Iris Pro”. 4 tháng 2 năm 2017.

- ^ Gary Key. “AnandTech - µATX Part 2: Intel G33 Performance Review”. anandtech.com. Lưu trữ bản gốc ngày 31 tháng 5 năm 2008.

- ^ Darren Murph. “Stanford University tailors Folding@home to GPUs”. Lưu trữ bản gốc ngày 12 tháng 10 năm 2007. Truy cập ngày 4 tháng 10 năm 2007.

- ^ Mike Houston. “Folding@Home - GPGPU”. Lưu trữ bản gốc ngày 27 tháng 10 năm 2007. Truy cập ngày 4 tháng 10 năm 2007.

- ^ “Top500 List - June 2012 | TOP500 Supercomputer Sites”. Top500.org. Bản gốc lưu trữ ngày 13 tháng 1 năm 2014. Truy cập ngày 21 tháng 1 năm 2014.

- ^ John Nickolls. “Stanford Lecture: Scalable Parallel Programming with CUDA on Manycore GPUs”. YouTube. Lưu trữ bản gốc ngày 11 tháng 10 năm 2016.

- ^ S Harding and W Banzhaf. “Fast genetic programming on GPUs”. Lưu trữ bản gốc ngày 9 tháng 6 năm 2008. Truy cập ngày 1 tháng 5 năm 2008.

- ^ W Langdon and W Banzhaf. “A SIMD interpreter for Genetic Programming on GPU Graphics Cards”. Lưu trữ bản gốc ngày 9 tháng 6 năm 2008. Truy cập ngày 1 tháng 5 năm 2008.

- ^ V. Garcia and E. Debreuve and M. Barlaud. Fast k nearest neighbor search using GPU. In Proceedings of the CVPR Workshop on Computer Vision on GPU, Anchorage, Alaska, USA, June 2008.

- ^ “Tensor Cores in NVIDIA Volta”. Nvidia. Nvidia. Truy cập ngày 16 tháng 8 năm 2018.

- ^ Smith, Ryan. “NVIDIA Volta Unveiled: GV100 GPU and Tesla V100 Accelerator Announced”. AnandTech. AnandTech. Truy cập ngày 16 tháng 8 năm 2018.

- ^ Hill, Brandon (11 tháng 8 năm 2017). “AMD's Navi 7nm GPU Architecture to Reportedly Feature Dedicated AI Circuitry”. HotHardware. HotHardware. Bản gốc lưu trữ ngày 17 tháng 8 năm 2018. Truy cập ngày 16 tháng 8 năm 2018.

Liên kết ngoài

[sửa | sửa mã nguồn]- NVIDIA - What is GPU computing?

- The GPU Gems book series Lưu trữ 2013-06-05 tại Wayback Machine

- - a Graphics Hardware History

- How GPUs work

- GPU Caps Viewer - Video card information utility

- OpenGPU-GPU Architecture(In Chinese)

- ARM Mali GPUs Overview Lưu trữ 2013-01-14 tại Wayback Machine

- GPU Rendering Magazine

GIẢM

29%

GIẢM

29%

GIẢM

32%

GIẢM

32%

GIẢM

20%

GIẢM

20%

GIẢM

22%

GIẢM

22%

GIẢM

15%

GIẢM

15%

![[Chap 1] Cậu của ngày hôm nay cũng là tất cả đáng yêu](https://i.imgur.com/4rvwvkh.jpg)